„Der Weltraum, ist groß, verdammt groß, du kannst dir einfach nicht vorstellen, wie groß, gigantisch, wahnsinnig riesenhaft der Weltraum ist. Du glaubst vielleicht, die Straße runter bis zur Drogerie ist eine ganz schöne Ecke, aber das ist einfach ein Klacks verglichen mit mit dem Weltraum.“

So lautet bekanntlich die Einleitung des Reiseführers „Per Anhalter durch die Galaxis“. Und diese Einleitung ist absolut korrekt. Das Universum IST verdammt groß und wir können uns diese Distanzen nicht vorstellen. Das Universum ist auch verdammt alt und das können wir uns ebenfalls nicht vorstellen. Wir wollen es uns aber gerne vorstellen, denn wir wollen Bescheid darüber wissen, was im Universum passiert und wie es sich entwickelt hat. Mit reiner Beobachtung ist es da aber nicht getan, denn wir können nicht die vielen Milliarden Jahre abwarten, innerhalb derer sich die diversen kosmologischen Prozesse abspielen. Aber das ist auch nicht nötig. Denn wir können uns ein künstliches Universum basteln und seine Entwicklung im Computer simulieren. Da dauert es dann vom Urknall bis zur Gegenwart nur noch ein paar Minuten und wir können in Ruhe alles erforschen was uns interessiert. Natürlich nur, wenn das simulierte Universum möglichst detailgetreu ist. Und was das angeht, haben Astronomen aus den USA, Deutschland und Großbritannien kürzlich einen wichtigen Schritt vorwärts gemacht.

Computersimulationen an sich sind natürlich keine große Neuigkeit sondern Standard in vielen wissenschaftlichen und technischen Bereichen. Aber besonders in der Astronomie sind sie von fundamentaler Bedeutung. Im Gegensatz zu anderen Disziplinen gibt es für die Astronomen keine Möglichkeit, ihre Studienobjekte direkt zu untersuchen und dazu kommt noch das Problem der langen Zeiträume. Man kann die Galaxien, Sterne und Planeten nicht aus unmittelbarer Nähe untersuchen und man kann ihnen nicht mal vernünftig dabei zusehen, wenn sie das machen, was sie machen. Will man wissen, wie Planeten entstehen, muss man ihnen Millionen Jahre lang zusehen. Will man wissen, wie sich ein Stern entwickelt, muss man ihn ein paar Milliarden Jahre lang beobachten. Und so weiter. Das ist in der Praxis natürlich unmöglich, also simuliert man diese Vorgänge im Computer.

In einigen Bereichen läuft das schon richtig gut. Wenn es zum Beispiel um die Bewegung der Himmelskörper geht, dann ist unser Wissen um die zugrunde liegenden Naturgesetze so gut, dass unsere Computersimulationen enorm genau sind. Wir können die Bewegung von Sonne, Erde und Mond so exakt vorhersagen um Sonnen- oder Mondfinsternisse mit hoher Genauigkeit zu prognostizieren. Wir wissen schon Jahre vorher wo genau sich im All ein Planet oder ein Asteroid befindet und können Raumsonden dort punktgenau landen lassen. Und es ist sogar vergleichsweise simpel, entsprechende Computermodell zur Simulation der Bewegung von Planeten zu schreiben bzw. zu benutzen (ich habe so ein Programm früher schon mal vorgestellt). Aber in anderen Bereichen wird es schon ein wenig schwieriger. Es ist immer noch ein absolut nicht-triviales Problem, die Vorgänge im Inneren eines Sterns am Computer zu simulieren. Es gibt natürlich jede Menge Forschung auf diesem Gebiet und die Leute die sich mit der numerischen Astrophysik beschäftigen haben teilweise enorm ausgeklügelte Programme geschrieben. Aber am Ende kann der Computer natürlich nur das simulieren, was wir ihm auftragen und so lange wir nicht ausreichend gut über die einzelnen Prozesse im Inneren der Sterne Bescheid wissen können wir dem Computer auch nicht sagen, was er simulieren soll.

Bei der Simulation des gesamten Universums kommt dann auch noch der immense technische Aufwand dazu. Ein paar Planeten im Computer um ihren Stern laufen zu lassen, ist heutzutage kein Problem mehr. Aber ein Kosmos voller Sterne, Galaxien, Gas, dunkler Materie, dunkler Energie, usw über die gesamte Lebensdauer des Universums zu simulieren, braucht schon ordentlich Computerpower. Zum Beispiel 8192 Prozessoren die 19 Millionen CPU-Stunden lang rechnen (was ungefähr 2000 Jahren Rechenzeit auf einem einzelnen Computer entspricht). So viel war nötig, um das Illustris-Projekt umzusetzen.

Die Ergebnisse dieser umfassenden kosmologischen Simulation sind nun kürzlich veröffentlicht worden („Properties of galaxies reproduced by a hydrodynamic simulation“). Und wenn man das gesamte Universum simulieren will, dann ist das nicht mehr ganz so einfach. Da reicht es nicht, einfach einen Haufen Sterne in den Computer zu schmeißen und ihre wechselseitige Gravitation und die daraus resultierende Bewegung zu berücksichtigen. Im All gibt es ja noch viel mehr als nur Sterne. Da ist zum Beispiel jede Menge Gas, aus dem neue Sterne entstehen können und Sterne leben auch nicht ewig. Man muss also schon mal ein paar grundlegende Prozesse der Sternentwicklung inkludieren und die Interaktion mit dem Gas berücksichtigen. Wenn ein Stern am Ende seines Lebens explodiert schleudert er ja auch wieder neues Gas ins All hinaus und mit simpler Gravitation ist es dann nicht mehr getan. Man muss dann auch die Hydrodynamik bei der Bewegung des Gases berücksichtigen. Und Galaxien sind ja auch nicht einfach nur Haufen aus Sternen sondern komplexe Objekte in denen noch viel mehr abgeht – zum Beispiel die Interaktion zwischen den zentralen schwarzen Löchern und der galaktischen Umgebung. Und selbst wenn man das alles in einem Computerprogramm unter einen Hut bekommt, fehlt noch die dunkle Materie die ja überhaupt erst dafür verantwortlich ist, dass sich die ursprüngliche Materie zu Strukturen wie Sternen und Galaxien zusammenklumpen kann und die dunkle Energie, die die Expansion des Alls beeinflusst.

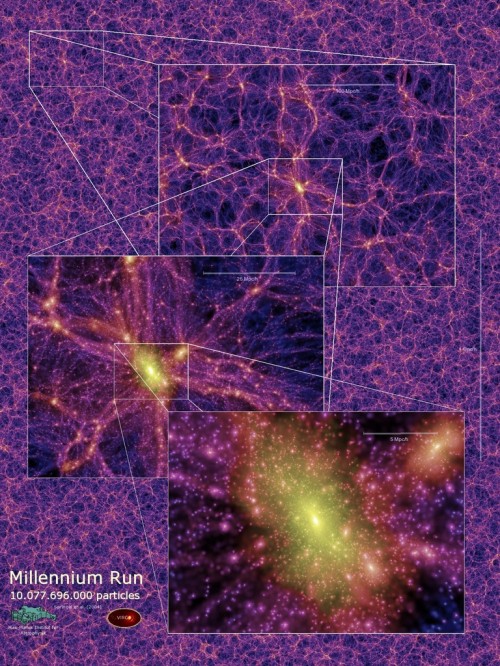

Es ist also ein ziemlicher Aufwand, so eine kosmologische Simulation zu erstellen. Trotzdem hat man es immer wieder probiert. Schon lange bevor die Leute vom Illustris-Projekt ihre Ergebnisse veröffentlicht haben, gab es zum Beispiel die Millenium-Simulation unter der Leitung des Max-Planck-Instituts für Astrophysik in Garching. Damals hat man im wesentlichen simuliert wie sich die dunkle Materie im Laufe der 14 Milliarden Jahre seit dem Urknall entwickelt hat und konnte zeigen, dass die kleinen Variationen in der Dichteverteilung der Materie die von Anfang an vorhanden waren sich im Laufe der Zeit tatsächlich zu der großräumigen Struktur entwickeln können, die wir beobachten. Aber rein technisch war man damals nicht in der Lage, auch die normale Materie zu berücksichtigen oder die Auflösung der Simulation so sehr zu erhöhen, dass man auch einzelne Galaxien (oder gar Sterne) erkennen kann.

Im Illustris-Projekt hat aber genau das funktioniert. Man hat neben der dunklen Materie auch normales Gas, Sterne, supermassereiche schwarze Löcher und die jeweiligen Interaktionen simuliert. Nicht für das gesamte Universum, aber immerhin für einen Würfel mit einer Kantenlänge von 350 Millionen Lichtjahren. Die Auflösung der Simulation beträgt knapp 160 Lichtjahre und das ist gut genug, um auch individuelle Galaxien sehen zu können. Man hat die Entwicklung des Universums für 13 Milliarden Jahre verfolgt, also fast während seiner gesamten Lebensdauer. Die Ergebnisse sind beeindruckend: Die über 41000 Galaxien der Simulation zeigen tatsächlich die gleiche Vielfalt wie die Galaxien die wir im echten Universum beobachten. Es gibt Spiralgalaxien wie unsere Milchstraße und große elliptische Galaxien – früheren Simulationen gelang es nicht, diese unterschiedlichen Formen zu reproduzieren. So sehen ein paar der Galaxien von Illustris aus:

Man kann auch direkt vergleichen, wie das „Illustris-Universum“ neben dem echten Universum aussieht. Dazu haben die Wissenschaftler ein Bild aus der Simulation erstellt, dass dem Blick auf das Hubble Ultra Deep Field entspricht. Links ist die Simulation, rechts die reale Beobachtung:

Damit man so eine gute Übereinstimmung bekommen kann, muss natürlich auch die Ausgangslage stimmen. Man muss vor allem die ursprüngliche Menge und Verteilung der dunklen Materie im Universum gut kennen. Es wird ja oft behauptet, die dunkle Materie sei nur reine Fiktion; von den Astronomen nur „ausgedacht“ oder „erfunden“. Dass das nicht so ist, habe ich ja schon in meiner Serie über dunkle Materie erklärt. Aber Simulationen wie Illustris zeigen das noch einmal sehr deutlich. Würde man die dunkle Materie nicht inkludieren und würde man nicht eine ganz bestimmte Menge an dunkler Materie inkludieren, dann würde man am Ende nicht ein Universum bekommen, dass dem realen Universum ähnlich ist. Und die richtige Menge an dunkler Materie ist in diesem Fall die Menge, die man auch aus anderen kosmologischen Beobachtungen ableiten kann.

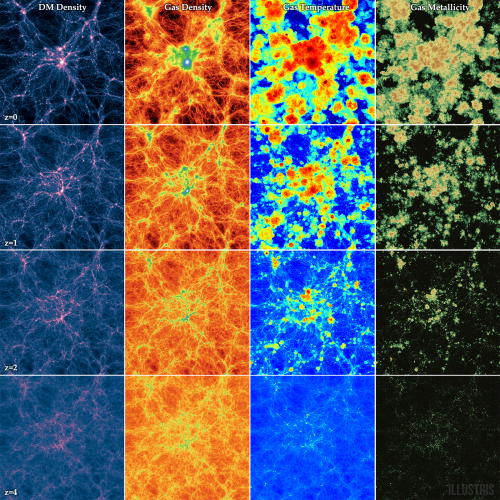

Illustris hat aber nicht nur die Entstehung von Galaxien beobachtet, sondern auch noch viele andere Eigenschaften. Zum Beispiel die Temperatur des Gases im Universum oder die Metallizität, also die Menge an schweren Elementen. Die Metallizität ist durch Beobachtungen und diverse kosmologische Berechnungen vorgegeben und eine vernünftige Simulation darf nicht zu sehr von den Beobachtungen abweichen. Dieses Bild zeigt einen kurzen Überblick über die Entwicklung des Illustris-Universum. Oben ist die Gegenwart; unten die Vergangenheit – ganz links ist die Verteilung der dunklen Materie zu sehen, daneben die Dichte des Gases, dann folgt die Temperatur des Gases und ganz rechts seine Metallizität:

Die Ergebnisse der Simulation stimmen auf vielen Ebenen mit den Beobachtungen überein. Die Zahl der Sterne in den Galaxien entspricht den Beobachtungen, genau so wie das Verhältnis zwischen sichtbarer und dunkler Materie. Und auch die Verteilung des Gases in und um die Galaxien sieht im Illustris-Universum so aus wie auch im echten Universum. Das schöne an einer guten Simulation ist aber nicht nur, dass man damit das nachvollziehen kann, was man schon beobachtet hat. Man kann sie auch benutzen, um neue Prozesse und Beobachtungen vorherzusagen und Dinge zu erforschen, die man in der Realität noch nicht beobachten kann. Genau das ist auch der eigentliche Zweck von Illustris. Man kann nun Vorhersagen über die Entwicklung von Galaxien und Galaxienhaufen machen und probieren das Problem der Satellitengalaxien zu lösen (die Zahl der theoretisch vorhandenen kleinen Satellitengalaxien in großen Haufen stimmt nicht mit den Beobachtungen überein), kann nachsehen welchen Einfluss die dunkle Materie tatsächlich auf die sichtbare Materie hat und vieles mehr. Man kann mit Illustris sogar „Fake“-Beobachtungen machen, also zum Beispiel simulieren, was das Hubble-Weltraumteleskop sehen würde, wenn es ein bestimmtes Phänomen oder Objekt beobachtet und das dann mit den echten Beobachtungen vergleichen bzw. abschätzen, ob sich Beobachtungskampagnen mit bestimmten Instrumenten überhaupt lohnen.

Illustris ist eine beeindruckende Simulation und es wird sicher noch einige Zeit dauern, bis man alles untersucht hat, was es in diesem künstlichen Universum zu entdecken gibt. Und wenn die Computer weiter so schnell besser werden, wie sie es bisher getan haben, dann werden wir sicherlich bald noch genauere und umfangreichere kosmologische Simulationen betrachten können. Bis dahin gibt es aber in der Welt von Illustris noch genug zu sehen:

Erstaunlich!

Sehr spannend!

Wenn die Simulation so gut mit den beobachteten Daten übereinstimmt, müsste man ja auch einen Blick in die Zukunft des Universums werfen können – also wie es z.B. in 20 oder 50 Mrd. Jahren aussieht.

Hat man die Simulation auch schon in die Zukunft weiter laufen lassen oder plant man das? Von der Rechenleistung her sollte das ja machbar sein.

Da die Simulation ja auf Daten aufbaut, die der Realität entnommen sind: Wie gross ist die Gefahr, hier einfach das zu „simulieren“ was man auch finden will (Gesetz der sich selbst erfüllenden Prophezeiungen) ?

auf den beitrag von dir zu illustris warte ich schon ne weile, FF; danke für 🙂

Teil des Problems ist natürlich die Fragestellung: Was muss ich in meiner Simulation eigentlich alles berücksichtigen?

AN dieser Stelle muss sich die Simulation der Realität stellen. Wenn nicht das heraus kommt, was heraus kommen sollte, dann gibt es 2 Möglichkeiten: Entweder ist das zugrundeliegende Modell grundsätzlich nicht geeignet, die Realität korrekt zu beschreiben. Oder, die zweite Möglichkeit, ich habe nicht alle wesentlichen relevanten Parameter im Modell.

D.h. eine der wichtigen Erkenntnisse aus einer Simulation, die die tatsächlich beobachteten Ereignisse auch ziemlich genau so reproduzieren kann, ist es, das man zu der Aussage kommt „Mit den benutzten Parametern und diesen konkreten Werten, reproduziert dieses Modell offenbar die Realität“.

D.h. die wesentlichste Aussage aus dieser Simulation lautet: Die Big Bang Theorie ist insofern stichhaltig, als eine Simulation basierend darauf, ähnliche Strukturen hervorbringt, die wir tatsächlich beobachten. Das heißt noch lange nicht, dass damit der Big Bang bewiesen ist. Es bedeutet nur, dass es erst mal keinen Grund gibt, ihn abzulehnen, denn wie sich gezeigt hat, entiwckelt sich in der Simulation mit diesen Annahmen und Parametern ein Universum, das ähnlich wie unserers aussieht.

Es könnte ja auch sein, dass dies eben nicht gelingt. Wenn das bei einem Simulationsversuch nach dem anderen, mit varrierenden Parametern bzw. wenn sich niemand mehr vorstellen kann, was man in der Simulation noch berücksichtigen müsste, reihum immer nur scheitern würde, dann würde der BB, bzw. das Model wie sich das Universum dann daraus entwickelt hat, einen schweren Stand haben.

@werner67

Gering. Man geht ja von einem recht primitiven Anfangszustand aus, der (natürlich) mit den Häufigkeiten von Materie, Dunkler Materie und Dunkler Energie abgeglichen sein muss, die man anhand der Hintergrundstrahlung messen kann, und dann wendet man nur noch bekannte Naturgesetze an und wartet, was herauskommt, ohne dass ein weiterer Abgleich mit der Realität statt findet. Wenn man etwas wesentliches vergessen hat, die Naturgesetze sich anders als bekannt verhalten (z.B. MOND) oder der Anfangsmix nicht stimmt, dann kommt am Ende irgendetwas anderes heraus, als man heute am Himmel vorfindet.

Wenn das Simulationsergebnis hingegen mit den Beobachtungen übereinstimmt, dann ist das ein guter Beleg dafür, dass man die Prozesse im Wesentlichen verstanden hat. Denn um diese geht es. Je näher das Simulationsergebnis der Realität kommt, desto besser hat man verstanden, was zwischen der Zeit kurz nach dem Urknall und heute abgelaufen ist.

Eine Abweichung gibt es ja noch, die kleinen Galaxien in der Simulation entstehen viel zu früh und ergeben dann in der heutigen Zeit 2-3 mal so alte Sternenpopulationen, wie tatsächlich beobachtet werden. Vielleicht stimmt ja die Anfangstemperatur der Dunklen Materie in der Simulation noch nicht oder dergleichen (nur mal so ins Blaue geraten). Man wird da sicherlich noch an freien Parametern drehen können, bis die Simulation auch diesen Aspekt korrekt wiedergibt und lernt dadurch etwas über den notwendigen Anfangszustand des Universums.

Danke für den interessanten Beitrag. Aber kannst du noch mal die Angabe von 350 Millionen Kubiklichtjahren für das simulierte Volumen überprüfen. Das erscheint mir doch etwas klein. Das entspräche einem Würfel mit der Kantenlänge von von rund 700 Lichtjahren.

@Daniel: Ja, ich meinte natürlich einen Würfel mit ner Kantenlänge von 350 Millionen Lichtjahren.

Die neue Simulation Illustris umfasst einen Würfel von etwa 350 Millionen Lichtjahren Kantenlänge (also bei fast 14 Milliarden Lichtjahren Ausdehnung nur einen relativ kleinen Teil).

( Zitat aus Telepolis: Die allerneueste Biografie des Universums, Matthias Matting, 08.05.2014,

https://www.heise.de/tp/artikel/41/41684/1.html )

*räusper*. trotz der kantenlänge steht allerdings immer noch „Kubiklichtjahre“.

Ich spreche ja auch vom 11dimensionalen Universum der Stringtheorie. Da haben Würfel Kantenlängen mit Kubiklichtjahren…

Ich kann mich erinnern, dass frühere Simulationen ein Problem hatten: Im Vergleich mit den Beobachtungen haben sie deutlich zu viele kleine Galaxien vorhergesagt. Hat sich dieses Problem inzwischen geklärt?

@Bjoern

Nicht mehr unbedingt zu viele, aber dafür zu frühe Zwerggalaxien, siehe #6, letzter Absatz (mit Link).

Nochmal zur Kantenlängenangabe: Im Video steht 35 Mio. Lichtjahre.

@Florian:

Bei dem Bildvergleich Illustris vs. Hubble ist mir aufgefallen, dass Simulation deutlich mehr kleine blaue Galaxien produziert. Wird das irgendwie im Artikel diskutiert?

Und was ich mich schon immer gefragt habe: Wer schreibt solche Programme? Tun das die Astrophysiker selbst oder wird das (zumindest in Teilen) an professionelle Programmierer ausgelagert?

@Havok: „Tun das die Astrophysiker selbst oder wird das (zumindest in Teilen) an professionelle Programmierer ausgelagert?“

Kann ich mir absolut nicht vorstellen. Um so ein Programm schreiben zu können braucht es Unmengen an astronomischen Wissen das Programmierer selten haben. Und Programmieren gehört in diesen wissenschaftlichen Bereichen genau so zum Handwerk wie die Beherrschung von Mathematik. Es ist kein Wunder das sehr viele Astronomen irgendwann mal die Wissenschaft verlassen und Programmierer werden… Abgesehen davon wäre sowieso kein Geld da, um irgendwelche externen Dienstleister zu bezahlen.

@Florian:

„@Havok: “Tun das die Astrophysiker selbst oder wird das (zumindest in Teilen) an professionelle Programmierer ausgelagert?”

Kann ich mir absolut nicht vorstellen. Um so ein Programm schreiben zu können braucht es Unmengen an astronomischen Wissen das Programmierer selten haben.“

Doch tut man. Muss man sogar.

Allerdings nicht in dem Sinne, dass man da externe Dienstleister beauftragt.

An so einem Projekt sind oft dutzende von Wissenschaftlern beteiligt. Und in diesem Bereich sind dann oft eben auch ein paar Informatiker dabei.

Ich habe selber mal an so einem Projekt mitgearbeitet (vor sehr, sehr vielen Jahren und in viel kleinerem Rahmen) und wir waren zwei Physiker (ein Doktorand und ich als Studi) und zwei Informatiker (auch Doktorand und Studi).

Insbesondere das Thema Simulationen auf Parallelrechnern ist technisch so komplex, dass man als Physiker / Astronom / Chemiker usw. gar keine Chance hat das mal eben so nebenher so tief zu durchdringen wie das ein Informatiker kann.

Während der / die Informatikerin sich nicht mal so nebenbei in Themen wie ART, Strömungsphysik oder Molekülchemie einarbeiten kann.

Deswegen tut man sich dann eben Zusammen …

@PDP10: „Insbesondere das Thema Simulationen auf Parallelrechnern ist technisch so komplex, dass man als Physiker / Astronom / Chemiker usw. gar keine Chance hat das mal eben so nebenher so tief zu durchdringen wie das ein Informatiker kann.“

Das mag manchmal so sein. Manchmal aber eben auch nicht. Ich kenne genug Astronomen die durchaus sehr komplexe Programme für Parallelrechner geschrieben haben (manche haben diese Rechner sogar zuerst noch gebaut!).

@FF: sorry 😉 und schöner joke.

@DasKleineTeilchen

Hatte den Witz von Florian erst nicht verstanden. 3x 3 Dimensionen + die Zeitdimension ergab bei mir nur 10 Dimensionen. Ich wunderte mich schon wo die 11. Dimension abgeblieben ist.

Das wird mir bei Illustris langsam zu kompliziert, da bleibe ich lieber bei EVE Online. 200 Lichtjahre Kantenlänge, eine etwas eigenwillige Interpretation der ART, dafür kann ich da aber munter mitsimulieren.