Zur Abwechslung macht gerade mal ein wissenschaftliches Thema abseits von Corona Schlagzeilen. Es geht um Teilchenphysik: Ein Experiment am amerikanischen Fermilab hat Hinweise auf „neue Physik“ entdeckt. Also auf etwas, was über das bisher bekannte „Standardmodell“, mit dem wir den Aufbau und das Verhalten der Materie beschreiben, hinaus geht. Das heißt: Bisher unbekannte Teilchen; eine bisher unbekannte fundamentale Kraft; vielleicht auch beides oder etwas völlig anderes. Auf jeden Fall neu; das sollen extrem präzise Messungen des g-Faktors von Myonen zeigen. Womit sich drei Fragen stellen: 1) Was ist ein Myon? 2) Was ist ein g-Faktor? Und 3) Wieso braucht man auf einmal „neue Physik“?

Was ist ein Myon?

[Kurze Antwort: Ein Elementarteilchen]

Fangen wir mit dem einfachsten Teil an. Myonen sind Elementarteilchen. Man kann es sich wie ein Elektron vorstellen, nur mit etwas mehr Masse (rund 200 Mal so viel). Im Gegensatz zum Elektron, das wir in der Hülle von Atomen finden, spielen Myonen beim Aufbau der normalen Materie allerdings keine Rolle. Das liegt unter anderem auch daran, dass sie instabil sind; sie existieren nach ihrer Entstehung nur für Sekundenbruchteile und wandeln sich dann in andere, stabile Teilchen herum. Entdeckt hat man die Myonen 1936 in der „kosmischen Strahlung“. Also die Teilchen, die von Sternen wie der Sonne und anderen astronomischen Phänomenen im Weltall andauernd produziert werden und durch den Kosmos fliegen. Wenn die kosmische Strahlung auf die Atmosphäre der Erde trifft, dann ist das im Prinzip wie ein natürlicher Teilchenbeschleuniger: Es kommt zu Kollisionen mit den Atomen der Luft und aus der dabei frei werdenen Energie können neue, andere Teilchen entstehen. Zum Beispiel Myonen, die man aber eben genau so gut auch künstlich in irdischen Beschleunigeranlagen erzeugen kann. Was man auch macht, da sich mit ihnen sehr viele spannende Phänomene sehr gut untersuchen lassen (dazu später mehr).

Was ist der g-Faktor?

[Kurze Antwort: Eine Zahl, die das Verhalten von Elementarteilchen beschreibt, und die man einerseits sehr gut theoretisch berechnen, andererseits aber auch sehr präzise messen kann]

Hier wird es ein wenig komplizierter. „g-Faktor“ steht für „gyromagnetischer Faktor“ (der auch „Landé-Faktor“ genannt wird). Und es geht um das „magnetische Moment“ eines Teilchens. Das könnte man sehr vereinfacht als die Stärke des Magnetfelds beschreiben, das einem Teilchen zueigen ist. Für den g-Faktor brauchen wir aber auch noch den „Spin“ des Teilchens. Der wird ja gerne mal als „Drehimpuls“ beschrieben und man stellt sich dann das Teilchen als kleines Kügelchen vor, das um eine Drehachse rotiert. Was man durchaus tun kann, aber nur wenn es einen nicht stört, dass es falsch ist. Denn Teilchen sind keine kleinen Kugeln die sich drehen. Wir haben es mit Quantenmechanik zu tun, und da werden die Dinge leider nicht mehr sehr anschaulich. Ein Beispiel: Teilchen wie Elektronen oder Myonen haben einen Spin von 1/2. Was bedeutet, dass sie sich zweimal um ihre Achse drehen müssen, damit sie wieder den gleichen Zustand erreichen wie vor Beginn der Drehung. Das macht nicht viel Sinn – eben weil die Vorstellung von sich drehenden Kugeln nicht der Realität entspricht. Mir ist bis jetzt für den Spin noch keine bessere „Erklärung“ eingefallen als: Der Spin eines Teilchens ist eine quantenmechanische Größe, für die es in der normalen Welt unseres Alltags keine Entsprechung gibt. Das ist zwar ein wenig unbefriedigend, aber wenn man nicht die ganze (und sehr komplizierte) Mathematik der Quantenmechanik auffahren will, dann muss man sich damit abfinden, dass man sich manche Dinge eben nicht gleichzeitig verständlich UND korrekt vorstellen kann.

Der g-Faktor beschreibt nun – wieder sehr vereinfacht gesagt – wie sich der Spin eines Teilchens bei Vorhandensein eines Magnetfelds verhält. Er bestimmt, wie schnell sich die Spin-Achse des Teilchens um die Magnetfeldlinien dreht. Das tun Elektronen und Myonen doppelt so schnell wie man es erwarten würde, wenn man die ganze Sache mit der Quantenmechanik sein lässt und die Teilchen mit klassischer Physik beschreibt. Weswegen der g-Faktor für diese Teilchen einen Wert von 2 hat. So zumindest lautete das Ergebnis, das man aus der berühmten Dirac-Gleichung ableiten kann, die 1928 entwickelt wurde, um die Quantenmechanik mit den Erkenntnissen von Albert Einsteins spezieller Relativitätstheorie zu kombinieren. Messungen in den 1940er Jahren haben aber immer wieder einen Wert geliefert, der ein kleines bisschen größer als 2 war (nämlich 2,00232). Das könnte man einfach ignorieren – aber die Quantenmechanik ist in der Lage, SEHR genaue Vorhersagen zu machen und man kann im Allgemeinen die Werte bei Experimenten in Teilchenbeschleunigern auch SEHR genau messen. So ein Unterschied zwischen Theorie und Experiment ist also durchaus relevant. Der amerikanische Physiker (und spätere Nobelpreisträger) Julian Schwinger fand dann auch bald heraus, wo das Problem liegt. In der Welt der Quantenmechanik ist nichts von Dauer; alles kann sich ändern. Teilchen wie Elektronen oder Myonen können zum Beispiel durch die Gegend fliegen und spontan ein Lichtteilchen, also ein Photon aussenden. Unmittelbar danach absorbieren sie das Photon wieder und tun so, als wäre nichts geschehen.

Das klingt seltsam, ist aber auch wieder der Natur der Quantenwelt zu verdanken. Ein Teilchen ist eben kein fixes „Ding“; keine Kugel, nicht einmal eine Welle (je nach dem wie wir hinschauen sehen sie für uns nur manchmal so aus wie Kügelchen oder Wellen) – sondern genaugenommen ein angeregter Zustand eines Quantenfeldes. Auch das kann man nicht wirklich gut anschaulich erklären. Vereinfacht gesagt: Je nachdem wie viel Energie in ein Quantenfeld gesteckt wird, tauchen daraus verschiedene Teilchen auf. Und weil in der Quantenmechanik nichts fix ist, ist so ein Feld beständig am fluktuieren. Es tauchen immer wieder Teilchenpaare auf und verschwinden sofort wieder. Wenn man sich ein Myon unbedingt als kleine Kugel vorstellen möchte, dann am besten als eine Kugel, die von einer sich dauernd ändernden Wolke aus anderen Teilchen umgeben ist. Denn das Beispiel mit dem Photon war nur der einfachste Fall. Auch das Lichtteilchen kann sich kurzfristig „verwandeln“; dann hätten wir ein Myon, das ein Photon aussendet, das sich in irgendein Teilchen/Antiteilchen-Paar umwandelt, das sich gegenseitig auslöscht und wieder zu einem Photon wird, das vom Myon schließlich absorbiert wird. Das ganze passiert ständig und in beliebig komplexen Erweiterungen.

Das ist verständlicherweise ziemlich verwirrend. Wichtig aber ist: Dieses ganze Teilchengewimmel um das Myon herum beeinflusst den Wert des g-Faktors. Es macht ihn ein klein wenig größer, womit ja eigentlich der Unterschied zwischen Theorie und Experiment wieder hergestellt sein sollte. Dann bräuchte man aber auch keine „neue Physik“ – weswegen die Geschichte jetzt eigentlich erst so richtig anfängt.

Warum braucht man eine „neue Physik“?

[Kurze Antwort: Weil die Messungen des g-Faktors der Myonen nicht mit den theoretisch berechneten Werten übereinstimmen und niemand weiß, warum das so ist.]

Was heißt es eigentlich, wenn man von „neuer Physik“ redet? Die „alte Physik“ ist in diesem Fall das sogenannte „Standardmodell der Teilchenphysik“. Das ist im Wesentlichen ein Haufen sehr komplizierter mathematischen Formeln, mit denen die Eigenschaften der Elementarteilchen beschreibt und der Kräfte, die zwischen ihnen wirken. Dieses Modell ist enorm erfolgreich; die theoretischen Vorhersagen die sich daraus berechnen lassen, stimmen mit extrem hoher Genauigkeit mit den Messungen überein. Beim g-Faktor für das Elektron etwa stimmen Theorie und Experiment bis auf 0,000000000001 überein. 12 Stellen hinter dem Komma; da können andere Wissenschaften schon ein wenig neidisch werden.

Das Standardmodell funktioniert also gut. Wir wissen aber, dass es in manchen Bereichen nicht funktioniert. Es ist zum Beispiel nicht in der Lage, auch die Gravitationskraft zwischen den Teilchen zu beschreiben. Es ist nicht in der Lage, Phänomene wie die dunkle Materie zu inkludieren. Oder Neutrinos korrekt zu beschreiben. So gut das Standardmodell also auch ist; es muss noch etwas besseres geben. Genau das ist die „neue Physik“: Etwas, was das Standardmodell grundlegend verändert; eine neue Art von Teilchen, eine neuen Kraft zwischen den Teilchen, und so weiter. Wir haben jede Menge Ideen, wie so eine neue Physik aussehen könnte. Aber bis jetzt haben wir noch keine ausreichend großen Abweichungen zwischen Theorie und Experiment entdeckt, die ein konkreter Hinweis auf die neue Physik wäre.

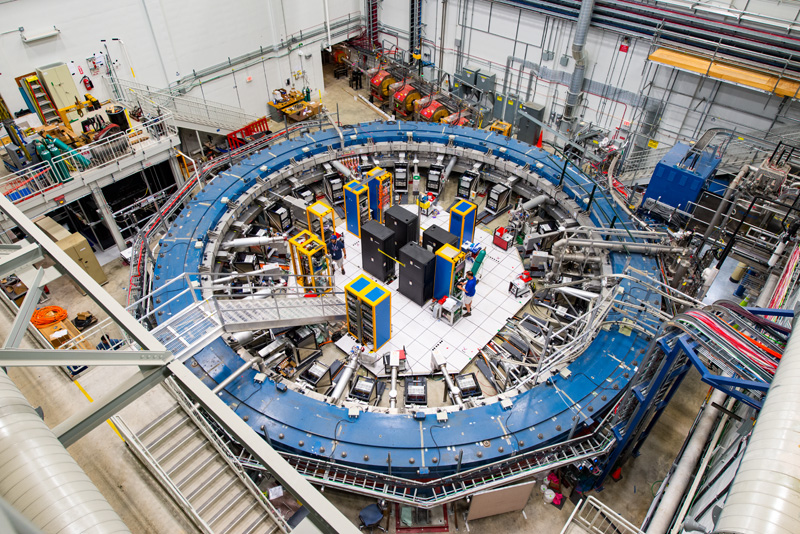

Zurück zu den Myonen: Die hat man schon seit den 1950er Jahren benutzt, um mehr über die Welt der Teilchen zu erfahren. Elektronen sind zwar einfacher, weil sie nicht zerfallen. Aber so ein Myon hat mehr Masse, was bedeutet, dass es auch viel massereichere Teilchen in seiner „Teilchenwolke“ erzeugen kann. Und genau dort könnten sich bisher unbekannte Teilchen verbergen (diejenigen mit kleiner Masse haben wir schon längst alle entdeckt). Wie untersucht man das jetzt genau? Einmal durch Experiment: In einem ringförmigen Teilchenbeschleuniger werden Myonen eingeschossen. Im Ring gibt es ein Magnetfeld und während das Myon dort seine Runden dreht, wackelt es ein wenig hin und her. Wieder einmal nur vereinfacht gesagt, natürlich. Irgendwann (nach einem Sekundebruchteil und ein paar hundert Runden im Ring), zerfällt es und zwar in dem Fall in ein Elektron und zwei Neutrinos. Die Energie des ausgesandten Elektrons kann man mit Detekoren messen und daraus lässt sich die Stärke des Wackels messen, die wiederum vom g-Faktor abhängt.

So kriegt man als den Messwert für den g-Faktor. Jetzt braucht man noch die Theorie. Dafür muss man eigentlich „nur“ rechnen; einfach ist es aber trotzdem nicht. Denn es gibt sehr, sehr, sehr viele Möglichkeiten für die Arten von Teilchen, die so ein Myon spontan aussenden und wieder absorbieren kann. Manche – wie der simple Fall eines Photons – sind häufig und leicht zu berechnen. Andere sind sehr kompliziert und kommen seltener vor. Und man hat auch nicht einfach eine Liste an möglichen Prozessen, die man einfach nur der Reihe abarbeiten muss. Alles passiert gleichzeitig und immer nur mit einer gewissen Wahrscheinlichkeit. Man kann sich der Realität nur Stückweise annähern und je genauer man werden will, desto mehr muss man rechnen. Das Verfahren nennt sich Störungsrechnung: Das auftauchende und verschwindene Photon ist zum Beispiel eine große „Störung“ des g-Faktors, aber leicht zu berechnen. Sollte das Photon unterwegs selbst noch einen Haufen andere Teilchen produzieren, ist die Störung geringer, aber auch viel schwerer und aufwendiger zu berechnen. Im aktuellen Fall hat man auf Seite der Theorie immer knapp 15.000 potentielle Teilchenreaktionen berücksichtigt; ein enormer Rechenaufwand, der aber auch ein sehr genaues Resultat liefert. Der g-Faktor des Myons sollte demnach 2,00233183620 betragen. Gemessen hat man am Teilchenbeschleuniger des Fermilab aber einen Wert von 2.00233184122. Eine Abweichung in der achten Stelle hinter dem Komma! Reicht das als Hinweis auf eine „neue Physik“?

Hat man wirklich eine „neue Physik“ entdeckt?

[Kurze Antwort: Vielleicht. Wir müssen noch ein wenig genauer hinschauen. Vielleicht liegt die neue Physik aber auch nicht dort, wo wir glauben, das sie zu finden ist.]

Entdeckungen in der Teilchenphysik laufen ein wenig anders ab als anderswo in der Wissenschaft. Ich habe das vor 10 Jahren schon mal ausführlich angesichts der Suche nach dem Higgs-Teilchen beschrieben. Da schaltet man nicht einfach den Teilchenbeschleuniger an und wartet, bis so ein Teilchen vorbei kommt auf das man dann mit dem Finger zeigt und „Da ist es!“ ruft. Die Experimente im Beschleuniger erzeugen JEDE MENGE Daten! Man kann dort zum Beispiel Teilchen kollidieren lassen. Dabei wird Energie frei und aus dieser Energie bilden sich neue Teilchen. Nicht nur die, die man gerade sucht, sondern alles, was die Gesetze der Physik zulassen. Das muss man irgendwie auseinander sortieren und kriegt es dabei leider mit Wahrscheinlichkeiten zu tun. Auch hier arbeitet man mit dem Vergleich von Theorie und Messung: Man berechnet vorher, welche Teilchen dort prinzipiell entstehen sollten und in welche anderen, stabilen Teilchen sie zerfallen. So bekommt man eine Vorhersage über die Verteilung der Energie, die diese gemessenen Teilchen haben sollten und das vergleicht man dann mit der realen Messung. Entstehen im Experiment Teilchen, mit denen man nicht gerechnet hat, also neue, noch unbekannte Teilchen, dann wird man eine Abweichung zwischen Theorie und Experiment messen. So weit, so klar. Aber weil in der Quantenmechanik eben nichts exakt sondern alles nur innerhalb gewisser Wahrscheinlichkeiten abläuft, kommt es zwangsläufig IMMER zu Abweichungen. Das ist ein wenig wie beim Würfeln: Die Theorie sagt, dass man jede Zahl zwischen 1 und 6 gleich oft und wahrscheinlich würfelt. Es kann aber trotzdem sein, dass ich per Zufall mal sechs Sechsen hintereinander würfle. Das liegt dann nicht daran, dass die Physik falsch ist. Sondern ist tatsächlich nur Zufall und wenn ich weiter würfle, werden die Resultate immer besser mit der Vorhersage übereinstimmen.

In der Teilchenphysik ist es auch so: Abweichungen zwischen Theorie und Experiment können auch einfach nur Zufall sein. Deswegen verwendet man dort den „Sigma-Wert“. Auch das habe ich in meinem alten Artikel genau erklärt; im Wesentlichen ist es aber eine Zahl die einem sagt, wie wahrscheinlich es ist, dass die Abweichung nur ein Zufall ist, der wieder verschwindet, wenn man mehr Daten sammelt. Beim aktuellen Experiment des Fermilab liegt der Wert bei 4.2 – was so viel heißt wie: Mit einer Chance von 99,997 Prozent ist die Abweichung NICHT durch Zufall entstanden. Das klingt eigentlich schon sehr gut; in der Teilchenphysik ist es aber üblich, erst bei einem Wert von 5 Sigma (99,99994% Sicherheit) von einer „Entdeckung“ zu sprechen. Was natürlich immer noch eine recht willkürliche Grenze ist: Es gab jede Menge Fälle, wo Experimente einen niedrigen Sigma-Wert gezeigt haben, der später gewachsen ist und sich als Anzeichen eines realen Phänomens herausgestellt hat. Und Messungen mit Werten von mehr als 5 Sigma haben sich als zufällige Fluktuation herausgestellt. Teilchenphysik ist keine Wissenschaft für singuläre „Heureka!“-Momente. Sondern ein kontinuierlicher Prozess, bei dem das Vertrauen (oder Misstrauen) im Laufe der Zeit immer größer wird, so lange bis irgendwann alle überzeugt sind, es mit einem realen Phänomen zu tun zu haben. Denn der Zufall kann uns zwar täuschen, aber nicht beliebig lange. Ein echtes Phänomen setzt sich immer durch; die zufälligen Fluktuationen verschwinden zwangsläufig irgendwann.

Halten wir also fest: Von einer „offiziellen“ Entdeckung kann man bei einem Wert von derzeit 4,2 Sigma noch nicht sprechen. Es stimmt aber optimistisch, dass das Experiment am Fermilab ja nur das letzte in einer langen Reihe war. Und dass der Sigma-Wert immer größer geworden ist, je mehr Daten man gesammelt hat. Dennoch brauchen wir NOCH mehr Daten, wenn wir es genau wissen wollen. Vor allem, weil es da noch ein anderes Problem gibt.

Ist alles doch nur ein Rechenfehler?

[Kurze Antwort: Eventuell. Aber auch das könnte ein Hinweis auf neue Physik sein]

Ich habe vorhin erwähnt, wie schwierig es ist, den g-Faktor des Myons aus der Theorie des Standardmodells zu berechnen. Das liegt vor allem an einem Phänomen, das man „hadronische Vakuum-Polarisation“ nennt. Das ist genau der Fall, den ich schon ein paar Mal erwähnt habe: Ein Myon sendet ein Photon aus, das Photon verwandelt sich in ein Hadron und ein Anti-Hadron, beide vernichten sich und das entstehende Photon wird vom Myon wieder absorbiert. Und ein „Hadron“ ist ein Teilchen, das aus Quarks zusammengesetzt ist. Das macht es schwierig, seine Eigenschaften genau zu berechnen, denn die Quarks werden von der „starken Kernkraft“ beeinflusst, die wiederum von „Gluonen“ vermittelt wird und bei diesem ganzen Prozess entstehen selbst wieder jede Menge Teilchenpaar die sofort wieder verschwinden. Man muss das alles nicht im Detail verstehen, wichtig ist nur: Der Einfluss der Hadronen auf den g-Faktor ist enorm knifflig zu berechnen. Man kann das vor allem nicht exakt tun; die entsprechenden mathematischen Formeln sind immer nur näherungsweise lösbar. Aber man will es lösen, denn der Einfluss der Hadronen ist zwar klein, aber wichtig. Je nachdem wie er ausfällt, ändert sich der g-Faktor ab der siebten Stelle hinter dem Komma – also genau da, wo es in diesem Fall interessant wird. Es gibt nun zwei Arten, das Problem anzugehen. Man kann ganz auf das Rechnen verzichten, stattdessen Daten aus anderen Experimenten nehmen und daraus den Einfluss der Hadronen ableiten. Das ist eine etablierte Methode, die schon oft und gut bestätigt worden ist und genaue Resultate liefert. Oder man kann das ganze per Computersimulation lösen. Die entsprechenden mathematischen Gleichungen sind zwar nicht exakt berechenbar, aber die Resultate lassen sich mit den entsprechenden Methoden im Prinzip beliebig genau mit einem Computer näherungsweise finden. Auch das ist nicht neu; auf diese Weise lösen wir zum Beispiel auch die Gleichungen, die die Bewegung von Himmelskörpern beschreiben und das klappt immerhin so gut, dass wir Raumsonden punktgenau zu absurd weit entfernten Planeten steuern können.

Im aktuellen Fall hat man am Fermilab den ersten Ansatz gewählt. Vor ein paar Wochen schon haben andere Forscher:innen aber ihre Resultate mit der zweiten Methode veröffentlicht. Das ganze läuft unter dem Namen „BMW-Team“ und hat nichts mit dem Auto zu tun, sondern mit Budapest, Marseille und Wuppertal, wo die diversen Arbeitsgruppen ansäßig sind. Sie haben einen Supercomputer benutzt um den g-Faktor inklusive der kniffligen Hadroneinflüsse extrem genau zu berechnen. Das Ergebnis: 2,00233183908. Was innerhalb der Größenordnungen um dies hier geht, deutlich größer ist als der für das Fermilab-Experiment verwendet Theoriewert von 2,00233183620 ist. Und auch sehr viel näher am gemessenen Wert von 2.00233184122 liegt.

Nimmt man die eine Rechenmethode als Grundlage, dann findet man also keine großen Hinweise auf neue Physik. Bei der anderen dagegen schon. Das ist ein wenig unbefriedigend. Und macht noch einmal deutlich, dass wir mehr Daten brauchen. Aber selbst wenn die Abweichung im Laufe der Zeit verschwinden sollte, hat man immer noch ein Problem: Warum stimmen die beiden Rechenmethoden nicht überein? Auch dafür muss es einen Grund geben und auch der könnte darin bestehen, dass wir beim Standardmodell irgendwas grundlegendes übersehen haben. Die Hoffnung auf die Entdeckung von „neuer Physik“ bleibt also bestehen!

Und was tun wir jetzt?

Wir warten ab. An den Teilchenbeschleunigern wird weiter gemessen werden. In der Theorie wird man probieren zu verstehen, wie man die Vorhersagen noch exakter berechnen kann. Irgendwann MUSS etwas passieren. Das Standardmodell kann nicht das Ende unserer Erkenntnis sein. Wenn wir der Natur lange genug mit neuen Experimenten und neuen Theorien auf die Nerven gehen, wird sie uns irgendwann verraten müssen, was da abgeht!

P.S. Wer noch mehr über das Thema lesen will, von Leuten die sich auf dem Gebiet sehr viel besser auskennen als ich, dem empfehle ich den Artikel „‘Last Hope’ Experiment Finds Evidence for Unknown Particles“ von Natalie Wolchover im Quanta-Magazin und „Is the Standard Model of Physics Now Broken?“ von Sabine Hossenfelder in Scientific American.

Wenn man sich das alles durch den Kopf gehen lässt, erstaunt es, dass es überhaupt irgendetwas stabiles geben kann. Oder zumindest etwas, das so tut, als ob! Mit einer gewissen Wahrscheinlichkeit…

@Captain E.:

Wenn man davon ausgeht, dass bestimmte Erhaltungssätze gelten (und dass es nur endlich viele Sorten von Elementarteilchen gibt), finde ich das nicht besonders überraschend. Wenn z.B. Energie und elektrische Ladung erhalten sind, dann muss das leichteste geladene Teilchen (also das Elektron) stabil sein.

Ein toll geschriebener Artikel, Florian. Danke!

Neue Physik klingt nach Stoll, Meyl und Turtur!

Habe heute den Artikel in der Nature dazu gelesen und dachte mir, na, da kommt bestimmt ein Artikel von Florian. Und schwupp – da ist er! Sehr gut geschrieben!

> Wir warten ab. An den Teilchenbeschleunigern wird weiter gemessen werden. In der Theorie wird man probieren zu verstehen, wie man die Vorhersagen noch exakter berechnen kann. Irgendwann MUSS etwas passieren.

Die Wartezeit kann man sich mit dem Review of Particle Physics (1808 pages) verkürzen: https://inspirehep.net/literature/1489868

@ Mistelberger

Und was ist jezt die conclusio? Ich geh mal davon aus, daß sie sich die Puplikation(en) bereits zu Gemüte geführt haben. Wäre nett, eine kurze Zusammenfassung zu geben 😉

An der Hintergrundstrahlung ist ersichtlich dass die Raumzeit partiell nicht 100% symmetrisch ist und der Cut-Off nicht vernachlässigt werden darf. Dadurch erlangt die Biometrie, „Leben“ und „Metron – Maß“, also die Vermessung von Lebewesen an Bedeutung. Die Raumkrümmung ist ein Phänomen, das zwischen Bosonen hervorgerufen wird. Bei Photonen und Gravitonen ist aber der geometrische Raum nicht am Vermessungsprozess beteiligt, denn E- und H-Feld bilden eine elektromagnetische Welle und werden selbst aus dem Innen und Außen gebildet. Ein Photon ist schon eine Kombination und besteht aus einem elektrischen, neg. geladenen und einem magnetischen, pos. geladenen Anteil. Eine lokale Messung wird eine Nulldifferenz gegenüber einer anderen lokalen Messung liefern, denn nur außenstehende Beobachter können einen Effekt wahrnehmen, da E- und H-Felder übergeordnet sind. Als Orientierung oder besser Händigkeit braucht man aber noch eine geometrische Eigenschaft und das ist der Linearimpuls. Unterhalb der Planklänge sind auf einem Metron die Ecken verschwommen und werden zum Wirkungsfaktor als Verhältnis bzw. Quadratur des Kreises/Ellipse. Eine Orientierung über den Normalenvektor der Fläche in Innen und Außen ist zwar gegeben aber entwickelt sich nun zum Linearimpuls. Rotationsimpulse werden von Punkt zu Punkt übertragen und addiert. Dabei wird die Rotation in der Verzahnung durch den Druck von einer Ebene auf die nächste als Linearimpuls mit entsprechendem Wirkungsgrad weitergegeben. Das sind dann die Dynamiken der Geometrien des Raumes als Rotationen oder auch Flüsse und bilden elementare Eigenschaften der Teilchen, so etwas wie den Spin mit gewisser Trägheit. Erst ihre Organisation zu komplexeren Strukturen lässt eine Klassifizierung in rechtshändig und linkshändig, sowie einen Drehsinn zu. Resonanzen zwischen Teilchen/Beobachtern können ohne Energieaustausch in gewissen Grenzen unterhalb des planckschen Wirkungsquantums mittels der Informationshydrodynamik den optimalen Zustand minimalster Energie halten. Elliptische Differentialgleichungen der 3 Ortskoordinaten (x, y, z) und drei Geschwindigkeitskoordinaten (vx, vy, vz) geben an, wie schnell sich ein Objekt in eine bestimmte Richtung bewegt. Durch diese 6 Koordinaten ist die Position eines (freien) Elektrons eindeutig bestimmt.

@Bernd: Sie werden es wieder ignorieren; ich sage es aber dennoch: Mein Blog ist kein Medium, in dem sie ihre Privatphysik publizieren können. (Die abgesehen davon nix mit echter Physik zu tun hat.)

Aber bitte folgen Sie gerne der Aufforderung von Uli! Würd mich interessieren.

@ Bernd Nowotnick

Ihre Überlegungen kann ich leider nicht nachvollziehen.

Dennoch habe ich eine Frage an Sie: Können Sie auf Basis Ihrer Überlegungen den Wert des g-Faktors des Elektrons und des Myons berechnen? Wenn ja, zu welchen Werten kommen Sie?

@ Uli

Was der Nowotnick da schreibt ist bestenfalls Satire,

möglicherweise ist er aber ein Alu-Mützchenträger.

In beiden Fällen antwortet man aber darauf nicht!

Risiko ist, daß er weitermacht.

Seine Ausführungen vernachlässigen ohnehin die 5G-Strahlung und sind deshalb wertlos!

Ja aber selbstverständlich doch – immerhin hats auf der Erde bloß 1g. Selbst Jupiter bringts nur auf 2.5g, wo bitteschön sollte also diese ominöse 5g-Strahlung herkommen?

Trotzdem ist sein Text bestenfalls als ‚durchwachsen‘ einzuordnen, positiv die Beleuchtung der landwirtschaftlichen Problemfälle Erbsen- und Hafer-Felder, geradezu grotesk dagegen der Schreibfehler ‚Metron‘. Ein MetHorn sollte nun wirklich in jedem Haushalt präsent sein!

Sehr geehrter Herr Freistetter,

ich bin nicht vorbereitet auf Fragen, kann also nur aus der Hüfte antworten und möchte nebenbei bemerken nicht an den gängigen Fakten zu rütteln.

Selbstverständlich ist meiner Meinung nach der g-Faktor das A und O jeglicher Kommunikation, hängt aber von den aktuellen E- und H-Feldern zwischen den beteiligten Beobachtern/Teilchen ab, da meiner Meinung nach auch die Lichtgeschwindigkeit von der Richtung und den Winkeln der Metronen untereinander abhängt:

Der g-Tensor als verallgemeinerte Form des g-Faktors der Flächenanordnung bei magnetischer/informationeller Resonanz ist zuständig für den Wirkungsgrad der winkelabhängigen Linienverbreiterungen und hat Maxima bei 90° Orientierungen, zeigt sich somit abhängig von der Struktur der Beobachter/Teilchen bei der Hyperfeinwechselwirkung in den Wertleitern.

[…] Hoffnung auf “neue Physik”: Das Muon g-2-Experiment von Florian […]

Herr Nowotnick hat eine eigene Homepage (einfach mal googeln, ich werde die jetzt sicher nicht auch noch verlinken), die voll ist mit solchem blühenden Blödsinn. Unter anderem versucht er damit auch die Homöopathie zu begründen. 😀

Also nein, ich denke, dass ist keine Satire – sondern er ist wirklich so komplett schräg drauf, wie es hier in seinen Kommentaren schon klingt. Da ist jeglicher Versuch einer Diskussion vergebens, der lebt komplett in seiner eigenen Welt.

@Florian Freistetter

super artikel der auch auf die schwierigkeiten und diskrepanzen der theorie-rechnung eingeht. danke dafür. davon liest man nämlich meistens nichts, das ist aber ein wichtiger punkt. damit könnten sich die unterschiede zwischen theorie und experiment nämlich möglicherweise auch ohne neue physik klären.

hättest du ein beispiel dafür? würde mich interessieren. danke

und gaaanz kleines nitpicking:

nein, das heißt es nicht.

unter der annahme der null-hypothese beträgt die wahrscheinlichkeit ein mindestens derart signifikantes resultat zu erhalten 0.003%. aber daraus kann man nicht schließen wie wahrscheinlich die null-hypothese ist.

#16

Ich denke Du triffst den Nagel auf den Kopf. Der Bernd, dieser Bernd, weil es gibt ja auch noch andere, lebt so was von in seiner eigenen Welt…..

Ich hab meiner Frau, Fachärztin für Allgemeinmedizin, mal die Homepage gezeigt.

Ihr Kommentar war ne Diagnose.

Ich denke noch’n Flo könnte da auch etwas zu sagen.

@FF

Ich denke die Ermahnungen an Bernd nützen nichts. Das ist auch nicht wirklich Privatphysik. Du wirst Bernd hier immer wieder aufschlagen sehen, er hat nämlich eine höhere Mission.

Es sei denn Du triffst drastischere Massnahmen.

Einfach ignorieren…

Nein, nicht ignorieren, sondern lachen. Solch einen Unsinn braucht man in schlechten Zeiten!

Ich finde es eigentlich schade, dass in der Physik im Englischen wie im Deutschen immer noch mit diesen sprachlich irreführenden Begriffen „Teilchen“ und „particle“ gearbeitet wird. Dann ist es doch auch kein Wunder, wenn sich die Nichtphysiker das einfach immer völlig falsch vorstellen.

@AndreasP

Wenn die Wellenfunktion eines Elektrons zusammenbricht, das Elektron also quasi lokalisiert wird, von was soll man deiner Meinung nach sprechen, wenn der Begriff Teilchen oder Particle nicht mehr erlaubt sein soll?

🙂

Um in der Denknähe von Teilchen zu bleiben, bietet sich aufgrund der Kleinheit ‚Keks‘ an.

Generell allerdings ist die Benennung bereits ~vergeben, durch Erweiterung der Semantik von ‚Quant‚ auf diese Dinger, die besser mittels Quanten-mechanik/-elektrodynamik/-feldtheorie/-… beschrieben werden.

@rolak

Danke rolak. Ich werde mal mit den Quanten auf Tuchfühlung gehen. Hallo Quant, ich bin Karl-Heinz und wer bist du? 😉

Das ist ja schon irgendwie krank. Ich hab hier lange nicht gelesen und erst recht nicht kommentiert, aber weil mir ein Arbeitskollege von dem Myonenrätsel erzählt hatte, war ich mir sicher, daß Florian da was in petto hat. Check. 🙂

Dazu:

Genau das isses. Dieser eine Satz sollte viel präsenter sein. Das würde einige Cranks so in die Flaute treiben, daß sie da nie wieder rauskommen.

Und wo wir gerade bei Cranks sind: ich hab, bevor ich den Artikel hier zu lesen angefangen hab, nur die Liste der Artikel aufgemacht, gesehen, daß Florian tatsächlich wie erhofft eine Abhandlung geschrieben hat (Danke an Florian übrigens – den angeblich dasselbe Thema behandelnden Artikel bei SPON wollte ich jetzt nicht wirklich als faktensichere Referenz abarbeiten) und dann meinen Blick gleich in die Kommentarauflistung schweifen lassen, erwartend, daß sich dort besonders viele Kommentare zum Myon-Artikel sehen lassen.

Auch check.

Jetzt zum seltsamen Teil: zusätzlich zu den Stammkommentatoren (Karl-Heinz, Rolak, Björn, Folke et al.) taucht der Name „Bernd Nowotnick“ in der Kommentarliste auf. Und mein erster Gedanke ist „100 Euronen: ein Crank“.

Flugs also den Artikel hier aufgemacht, runtergescrollt bis zum ersten Kommentar von „Bernd Nowotnick“, et voilà: dreimal so lang wie alle anderen Kommentare, und er beginnt mit „An der Hintergrundstrahlung ist ersichtlich dass die Raumzeit partiell nicht 100% symmetrisch ist “ – was auch weniger physikalisch gebildeten Menschen entweder einen Lachkrampf oder heftiges Bauchgrimmen bescheren sollte. Die darauf folgenden Kommentare der anderen Stammleser zeigten dann dankenswerterweise auf, daß mein Crankdetektor immer noch ziemlich gut geölt ist.

Frage also: warum merkt man das schon am Anzeigenamen?

@ Bullet

Anfangs dachte ich noch, dass dieser Herr in Wirklichkeit ein KI-Bullshit-Bot ist und nur getestet werden soll, wie lange man darauf hereinfällt. Inzwischen musste ich erkennen, dass es tatsächlich Leute zu geben scheint, die so drauf sind. Aber immerhin haben seine sloterdijkschen Formulierungen manchmal einen höheren Unterhaltungswert als bei den ansonsten üblichen bierernsten Privatphysikvorlesungen der Ingenieure in Rente, die hier des Öfteren aufschlagen.

@Bullet

Erstens kennt man ja die üblichen Namen, die als Stamm- oder Gelegenheitskommentatoren hier auftreten.

Zweitens lockt ein Thema wie dieses immer wieder Cranks an, obwohl ihre wirren Ideen nicht wirklich was mit dem Thema zu tun haben, bzw. haben sie mit der Realität generell nichts zu tun.

Drittens neigen diese Typen dazu, unter Echt-Vor- und Nachnamen bzw. einem Nick der zumindest so aussieht zu kommentieren.

Dann braucht man nur noch die Kommentarlänge und den ersten Satz zu sehen, und Bingo!

Beim Stern Gerlach Versuch benötigt man ein inhomogenes Magnetfeld . Warum? Das wird im Video sehr schön erklärt. Jetzt weiß ich auch, was da wackelt. Bei dem obigen Experiment mit dem Myon ist ein inhomogenes Magnetfeld nicht sinnvoll, da das Myon eine Ladung trägt und die Lorenzkraft viel zu stark wäre und eine g-2 Messung unmöglich machen würde. Wenn ich jetzt das Experiment richtig verstanden habe, wird das Wackeln (Präzession) des Myons gemessen.

Jetzt kann ich viel besser schlafen. 🙂

Stern Gerlach Versuch

@stone1:

Das war ja genau mein Vorgehen. Aber ich mußte nur den Namen lesen, um bereits den Detektor zu spüren. War lustig.

Und man weiß sofort das es einer ist, wenn er (es ist interessanterweise immer ein „er“) seinen Namen nach altdeutscher Bürokratie-Art in der Reihenfolge Nachname, Vorname als Nick wählt …

https://www.quantamagazine.org/muon-g-2-experiment-at-fermilab-finds-hint-of-new-particles-20210407

@Karl-Heinz: Ja, das ist genau der Artikel den ich am Ende extra empfohlen habe.

@Reggid

Wenn du einen systematischer Fehler machst kannst mit 5 Sigma auch brausen gehen. Ich denke da an Überlichtgeschwindigkeit. 😉

@FF

Sorry, ich surfe schreibe meistens auf dem Handy.

Ich nehme mir aber vor, dass ich in Zukunft auf dem PC prüfe, ob der Link im Beitrag schon vorhanden ist, bevor ich einen Link poste.

Ich hatte deinen Link ganz zum Schluss schon entdeckt, aber da ist das Kind schon in den Brunnen gefallen. 😉

„Je nachdem wie viel Energie in ein Quantenfeld gesteckt wird, tauchen daraus verschiedene Teilchen auf. Und weil in der Quantenmechanik nichts fix ist, ist so ein Feld beständig am fluktuieren. Es tauchen immer wieder Teilchenpaare auf und verschwinden sofort wieder.“

Nichts ist dauerhaft fix. Im unendlichen Kleinen sind die Abläufe auch unendlich schnell. für uns sieht das nur aus wie „alles auf einmal“.

„Warum braucht man eine “neue Physik”?

[Kurze Antwort: Weil die Messungen des g-Faktors der Myonen nicht mit den theoretisch berechneten Werten übereinstimmen und niemand weiß, warum das so ist.]“

Wir brauchen vor Allem einen völlig neuen Denkansatz:

Es gibt weder das Kleinste noch das Größte.

Es gibt also weder das Nichts noch Tod. Es befindet sich überall das unendlich Kleine, also auch im Vakuum oder in Freiräumen/Zwischenräumen.

In der Theorie mag die 0 eine brauchbare Krücke sein, ab einem gewissen Punkt funktioniert das aber nicht mehr. An dem sind wir in diesem Beispiel angekommen.

Es gibt nicht 0, nur UNENDLICH GEGEN 0.

@How: „Es gibt nicht 0, nur UNENDLICH GEGEN 0.“

Sowas klingt immer schön beeindruckend, nicht? Hat aber halt nix mit Wissenschaft zu tun. Es sei denn, du kannst aus pseudophilosophischen Trivialitäten wie „Es gibt also weder das Nichts noch Tod. Es befindet sich überall das unendlich Kleine, also auch im Vakuum oder in Freiräumen/Zwischenräumen.“ konkrete Zahlenwerte zum Beispiel für Naturkonstanten wie die Lichtgeschwindigkeit ableiten oder Messwerte wie den Landé-Faktor vorhersagen…

@Karl-Heinz

ja das ist sowieso klar, aber im artikel steht

und dein beispiel mit einem systematischen fehler ist keines wo sich etwas als zufällige fluktuation herausgestellt hat.

@Florian

Ich glaube ja auch gar nicht, dass nichts schneller ist als Licht.

Meiner Logik nach gibt es genau zwei HAUPT-Naturkonstanten: Unendlich ins Große und unendlich ins Kleine (also gegen 0).

Darüberhinaus, denke ich, dass sich prinzipiell alles im Großen wie im Kleinen unendlich wiederholt. Der Kosmos besteht aus Kosmen.

Zuletzt erklärt in meinen Kommentaren zu Deinem Artikel

https://scienceblogs.de/astrodicticum-simplex/2020/11/02/das-geheimnis-der-dunklen-galaxie/?

@How: „Meiner Logik nach gibt es genau zwei HAUPT-Naturkonstanten: Unendlich ins Große und unendlich ins Kleine“

Dann bitte: Rechne vor, wie sich aus diesen „Konstanten“ der Wert der Lichtgeschwindigkeit ableiten lässt. Oder wie man laut deiner „Theorie“ die Bewegung der Planeten um die Sonne mathematisch beschreiben soll. Ich weiß, für dich fühlt sich das, was du sagst, wie Wissenschaft an und wie eine neue Erkenntnis. Aber so funktioniert Wissenschaft nicht. Da reicht es nicht, einfach nur irgendwas grandios klingendes zu erzählen. Es gibt einen Status Quo. Es gibt Unmengen Beobachtungen, Daten, Messungen, etc. Wenn deine „Theorie“ nicht in der Lage ist, den Status Quo zu erklären und das BESSER tut als das, was wir jetzt haben, dann ist sie nichts wert. Sorry. (Und wenn sie nicht mathematisch formulierbar ist, dann auch nicht).

…will sagen, dass wir im Kleinen an einem Punkt angekommen sind, wo unsere Mathematik nicht mehr funktioniert, weil zu ungenau. Weil es die 0 in der Realität nicht gibt, und weil wir diese Winzigkeiten nicht mehr messen können.

So wie wir umgekehrt im Großen auch nicht messen oder berechnen können, was vor dem Urknall war, bzw. wie groß unser Universum ist und wie es „darüber hinaus“ aussieht.

Und jenseits der Mathematik bleiben nur noch Logik, Intuition, Vergleich (von Ähnlichkeiten) und Wahrscheinlichkeit. Oder Religion.

@FF

Eigentlich sind diese Gedanken seit Aristoteles bekannt („Wie im Großen so im Kleinen“/horror vacui). Ich habe sie nur weitergedacht und mit dem Status Quo, dem ich im Allgemeinen nicht widerspreche, verglichen und kombiniert.

Mir geht es um eben diesen Grenzbereich der Wissenschaft, ab dem sie nicht mehr weiterkommt. Wie gesagt: Da ist nichts mehr mit Rechnen. Keine Beweise, nur noch Wahrscheinlichkeiten. Und ich meine nicht die Stochastik.

@How: Ok. Lassen wir das.

@Florian:

Mich würde mal interessieren, wie Physiker das eigentlich mit dem Anschaulichkeitsproblem bei Elementarteilchen machen – also z.B. du. Wie stellst du dir ein Teilchen vor? Oder versuchst du auch in einem eigenen Selbst dieser Frage aus dem Weg zu gehen, dich nur auf die Gleichungen zu konzentrieren und zu schauen, was sie letztlich bedeuten?

Zweite Frage (zum angeregten Zustand eines Quantenfeldes):

Sind Felder in ihrer Ausdehnung unendlich?

@FF

Ne, ne. Im Gegenteil, jetzt gehts erst richtig los. Die Sache ist in der Welt.

Ich möchte nochmal darauf hinweisen, das das Doppelspalt-Experiment (Du hattest es letztens zum Thema) GERADE ein Beweis darstellt für das (hypothetische) unendliche Kleine (vormals „Äther“). Dieses Experiment zum Beweis zu machen, dass Photonen und auch RICHTIG GROßE Teilchen „Wellenform“ UND „Teilchenform“ „annehmen“ können, so wie es ihnen „beliebt“… Das ist gelinde gesagt irre Unlogik! Und dann noch sollen sie masselos sein… „MASSELOSE TEILCHEN“ – DAS ist „beeindruckende Pseudophilosophie“.

Das UK ist die Trägersubstanz, „Quantenfelder“, „dunkle Energie/Materie“.

Diese gerät durch die Teilchen (ja, TEILCHEN mit Masse) in Schwingung und lenkt sie in Wellenform durch den Spalt.

So einfach ist das. Die Natur ist weder kompliziert noch grausam, noch spooky und vor allem hält sie für uns weder „Himmel“ noch „Hölle“ bereit.

Weg mit den Schreienden Päpsten! Weg mit ihrem Zombie-System!

@How: “ Im Gegenteil, jetzt gehts erst richtig los. „

Aber nicht hier. Hier geht es um Wissenschaft. Das was du hier als deine Wissenschaft verkaufen willst, sind pseudophilosophische Trivialitäten. Mit denen kann man leichtgläubige Menschen spätabends auf ner Party beeindrucken und Tiefgründigkeit vortäuschen. Aber mit irgendeiner seriösen Form der Erkenntnis hat das nichts zu tun.

Und bevor du der Wissenschaft erklärst, wie falsch sie liegt und dass du alles besser weißt, solltest du dich BITTE ein wenig informieren.

„. Dieses Experiment zum Beweis zu machen, dass Photonen und auch RICHTIG GROßE Teilchen “Wellenform” UND “Teilchenform” “annehmen” können, so wie es ihnen “beliebt”… Das ist gelinde gesagt irre Unlogik! „

Das Doppelspaltexperiment hat nicht den Zweck zu beweisen, dass Photonen mal ein Teilchen und mal ne Welle sind… Wie gesagt: Beschäftige dich erstmal mit dem, was man weiß, bevor du anfängst allen zu erklären, du wüsstest es besser.

Tschüß!

@ How? – Lennon

Ich würde es sehr begrüßen, wenn du der Bitte von Florian Freistetter in #44 nachkommen könntest. Er wird hoffentlich nicht mehr auf dich reagieren und mir (und ich denke auch vielen anderen) gehst du mit deinem Privatthesen(Pyhsik ist das ja nicht)-Gewäsch tierisch auf die Nerven. Die Phase, in der dein Geblubber noch teilweise erheiternd war, ist schon lange vorbei.

[…] Hoffnung auf “neue Physik”: Das Muon g-2-Experiment […]