Dieser Artikel ist Teil einer fortlaufenden Besprechung des Buchs „Die perfekte Theorie: Das Jahrhundert der Genies und der Kampf um die Relativitätstheorie“* (im Original „The Perfect Theory: A Century of Geniuses and the Battle over General Relativity“* von Pedro Ferreira. Jeder Artikel dieser Serie beschäftigt sich mit einem anderen Kapitel des Buchs. Eine Übersicht über alle bisher erschienenen Artikel findet man hier

Dieser Artikel ist Teil einer fortlaufenden Besprechung des Buchs „Die perfekte Theorie: Das Jahrhundert der Genies und der Kampf um die Relativitätstheorie“* (im Original „The Perfect Theory: A Century of Geniuses and the Battle over General Relativity“* von Pedro Ferreira. Jeder Artikel dieser Serie beschäftigt sich mit einem anderen Kapitel des Buchs. Eine Übersicht über alle bisher erschienenen Artikel findet man hier

——————————————————-

Im ersten Kapitel des Buchs haben wir erfahren, was eigentlich das allgemeine an der Allgemeinen Relativitätstheorie ist und wie Albert Einstein überhaupt auf die Idee kam, sie zu entwickeln. Im zweiten Kapitel hat Einstein dann mühsamer Rechnerei endlich herausgefunden, wie er diese Theorie formulieren kann. Das dritte Kapitel hat gezeigt, dass wir aus der allgemeinen Relativitätstheorie überraschend viel über die Entstehung des Universums lernen können. Und Kapitel vier demonstriert, dass das noch lange nicht alles ist!

Die Lösungen der Einsteinschen Feldgleichung die im letzten Kapitel vorgestellt wurden bezogen sich auf das gesamte Universum und haben die Wissenschaftler zu der überraschenden Erkenntnis gebracht, dass unser Kosmos einen Anfang hatte und nicht statisch ist. Aber die Lösungen von de Sitter, Friedmann und Lemâitre waren nicht die ersten, die gefunden wurden. Schon kurz nachdem Einstein seine Gleichungen im Jahr 1915 veröffenlichte, bekam er Post von einem deutschen Astronom. Karl Schwarzschild hatte die Feldgleichungen gelöst, sich aber dabei nicht gleich dem ganzen Universum gewidmet, sondern nur nachgesehen, wie sich die Gravitation in der Nähe einer sphärischen Masse verhält („Über das Gravitationsfeld eines Massenpunktes nach der Einsteinschen Theorie“).

Das ist im Prinzip genau die Situation, die in der Umgebung eines Sterns herrscht. Ein Stern ist eine große sphärische Masse und tatsächlich zeigte Schwarzschild, dass sich weit genug vom Stern entfernt die Einsteinschen Gleichungen zu der lange bekannten Newtonschen Gravitationsgleichung vereinfachten. Aber in der Nähe des Sterns gab es Unterschiede! Diese Unterschiede waren zum Beispiel dafür verantwortlich, dass man bei der Berechnung der Position des Merkurs mit Newtons Formel nur falsche Ergebnisse bekam. Einsteins Gleichungen dagegen lieferten ein korrektes Resultat. Schwarzschild zeigte aber auch, dass noch näher am Stern noch seltsamere Dinge passierten.

Kommt man der sphärischen Masse nur nahe genug, dann gibt es eine bestimmte Grenzfläche, innerhalb derer die Gravitationskraft so stark ist, dass man sich schneller als das Licht bewegen müsste, um ihr entkommen zu können. Und da nichts schneller als Licht sein, kann nichts mehr entkommen, was diese Grenze einmal überschritten hat. Albert Einstein präsentierte Schwarzschilds Lösung Anfang 1916 der Öffentlichkeit, war aber davon überzeugt, dass die komische Grenzfläche nur ein mathematischer Effekt war, der in der Realität nicht vorkommen würde.

Das dachte auch Arthur Eddington. Der Mann, der die Gültigkeit der Allgemeinen Relativitätstheorie durch die Messungen während der Sonnenfinsternis 1919 (ich habe darüber in Teil 2 geschrieben) bestätigte, entwickelte sich in den 1920er Jahren zum Experten für die Entwicklung der Sterne. Damals wusste man ja noch nicht so wirklich, wie das mit den Sternen funktioniert und wie sie ihre Energie erzeugen. Eddington war maßgeblich an der Lösung dieses Problems beteiligt und erklärte in seiner Arbeit, wie im Inneren der Sterne durch die Fusion von Wasserstoff zu Helium Energie erzeugt wird und diese vom Kern des Sterns nach außen dringende Strahlung der Gravitationskraft entgegen wirkt und den Stern im Gleichgewicht hält.

Wie es mit den Sternen zu Ende geht, wusste er aber noch nicht. Irgendwann ist der Brennstoff verbraucht, es wird keine neue Strahlung produziert, die Gravitation gewinnt die Überhand und der Stern kollabiert. Und dann?

„Es ist ein eigentümliches Problem, und es lassen sich viele fantasievolle Szenarien erdenken für das, was dann tatsächlich passieren wird.“

schrieb Eddington.

Zuerst dachte man, man hätte die Lösung in den weißen Zwergen gefunden. Diese seltsamen Objekte waren einerseits schwer wie Stern, andererseits aber nur so groß wie die Erde. Sie waren enorm dicht und waren offensichtlich das, was von einem Stern übrig bleibt, wenn der Druck der Strahlung wegfällt und der kollabiert. Der Astronom Ralph Fowler nutzte die Erkenntnisse der noch frischen Quantenmechanik, um den dichten Zustand zu erklären. Ende der 1920er Jahre formulierten Werner Heisenberg und Erwin Schrödinger die mathematischen Grundlagen dieser neuen physikalischen Theorie zu der auch die berühmte Unschärferelation gehört. Man kann nicht gleichzeitig über Position und Geschwindigkeit eines Teilchens Bescheid wissen. In einem kollabierenden Stern rücken die Teilchen aber immer dichter zusammen, sie haben also immer weniger Platz und ihre Position ist dadurch immer besser bestimmt. Das bedeutet, dass sich ihre Geschwindigkeit immer mehr erhöhen muss und das führt zu einem starken Druck. Dieser Quantendruck wird irgendwann stärker als die ihm entgegenwirkende Gravitationskraft und der Kollaps endet. Aus dem kollabierenden Stern ist ein weißer Zwerg geworden. Und da der Kollaps eines toten Sterns eben so nicht beliebig weiter gehen kann, besteht auch keine Gefahr, dass sich die Masse irgendwann innerhalb der mysteriösen Grenzfläche von Schwarzschild ansammelt. Eddington und Einstein waren zufrieden mit Fowlers Arbeit, die ihren Glauben daran bestätigte, dass die Realität die seltsame Lösung von Schwarzschild nicht zulassen würde.

Diese Arbeit von Ralph Fowler las auch der junge Subrahmanyan Chandrasekhar auf seinem Weg von Indien nach England. Und er merkte, dass Fowler einen Fehler gemacht hatte. Er hatte Einsteins spezielle Relativitätstheorie nicht berücksichtigt! Damit ein ausreichend großer Quantendruck aufgebaut werden kann, müssen sich die Teilchen schnell genug bewegen. Und sie können sich eben nicht beliebig schnell bewegen, da die Lichtgeschwindigkeit nie überschritten werden kann. Als Chandrasekhar die Geschwindigkeit der Teilchen korrekt nach der Relativitätstheorie berechnete, merkte er, dass es darauf ankommt, wie schwer der Stern ist. Sterne mit geringer Masse üben nur eine geringer Gravitationskraft auf ihre Zentrum aus, so dass der Kollaps durch den Quantendruck gestoppt werden kann. Sterne mit größere Masse aber kollabieren so heftig, dass der Quantendruck nicht mehr ausreicht um ihn aufzuhalten. Sie kollabieren weiter und auf einmal war Schwarzschilds seltsame Grenze wieder aktuell.

Chandrasekhar rechnete alles genau durch, zeigte, dass seine Ergebnisse zwingend aus Relativitätstheorie und Quantenmechanik folgten und präsentierte die Arbeit vor der Royal Astronomical Society. Eddington war trotz allem nicht zu überzeugen: „Es muss ein Naturgesetz geben, das verhindert, dass sich ein Stern in dieser absurden Weise verhält!“, verkündete er und Chandrasekhar war vom Widerspruch des berühmten Astronomen so verunsichert, dass er das Thema komplett aufgab und sich anderen Forschungsgebieten widmete.

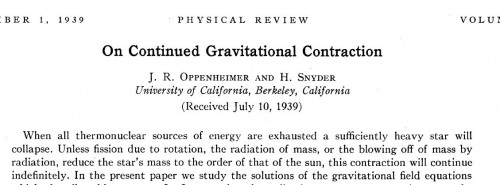

Erst im Jahr 1939 wurde die Idee wieder aufgegriffen und zwar von Robert Oppenheimer und Hartland Snyder. Die beiden untersuchten einen Vorschlag des russischen Physikers Lew Landau, der dachte, im Inneren von Sternen könnte es Neutronenkerne geben. Das sollte enorm verdichtete Materie sein, die für die Energieproduktion der Sterne verantwortlich ist. Oppenheimer und seine Kollegen konnten zeigen, dass dieses Modell nicht funktionieren würde. Sie konnten aber auch zeigen, dass die Einsteinschen Feldgleichungen tatsächlich eine Lösung beinhalten, nach der sich die Materie eines ausreichend schweren Sterns so stark komprimiert, um innerhalb der Schwarzschildschen Grenzfläche zu landen.

Das, was Oppenheimer, Chandrasekhar und Schwarzschild beschrieben hatten, ist das, was wir heute ein „Schwarzes Loch“ nennen. Es entsteht, wenn ein Stern schwerer ist als das Chandrasekhar-Limit (circa die 1,4fache Sonnenmasse) und beim Kollaps kleiner wird als der Schwarzschild-Radius bzw. der Ereignishorizont. Alles was den Ereignishorizont überschreitet, kommt nicht mehr zurück. Nicht einmal Licht, und deswegen ist das schwarze Loch ja auch schwarz.

Damals konnte man zeigen, dass zumindest theoretisch nichts dagegen spricht, dass schwarze Löcher entstehen können. Es gibt kein Naturgesetz das verhindert, dass der Stern sich auf „diese absurde Weise“ verhält. Ob es aber in der Realität tatsächlich schwarze Löcher gibt, wusste man nicht. Noch nicht…

„Man kann nicht gleichzeitig über Position und Geschwindigkeit eines Teilchens Bescheid wissen. In einem kollabierenden Stern rücken die Teilchen aber immer dichter zusammen, sie haben also immer weniger Platz und ihre Position ist dadurch immer besser bestimmt. Das bedeutet, dass sich ihre Geschwindigkeit immer mehr erhöhen muss und das führt zu einem starken Druck.“

Die Folgerung verstehe ich nicht so ganz. Müsste aus der Unschärferelation nicht einfach folgen, dass bei genauer Positionsbestimmung nichts über die Geschwindigkeit der einzelnen Teilchen ausgesagt werden kann? Woher kommt dann die Schlussfolgerung, dass die Geschwindigkeit immer größer werden muss?

@Bruno

Das mathematische Maß für die ungenauigkeit der Geschwindigkeit hängt davon ab, wie groß die Wahrscheinlichkeit für unterschiedliche Geschwindigkeiten ist. Wenn ich einen Würfel habe, der nur 6 Seiten hat, dann ist die Unsicherheit beim Würfeln eben kleiner als bei einem Würfel mit 20 Seiten – und bei dem kann ich auch mal ne 20 würfeln.

So ähnlich ist es auch bei der Unschärfe: Wenn die Geschwindigkeitsunschärfe sehr groß sein soll, dann muss es eben auch eine Wahrscheinlichkeit für sehr große Geschwindigkeiten geben.

@MartinB: ok, aber wie folgt dann der Schluss, dass es hohe Geschwindigkeiten sein müssen, obwohl es an sich erstmal eine Wahrscheinlichkeit gibt, dass solche Geschwindigkeiten auftreten? Ist die Wahrscheinlichkeit anderweitig bekannt?

Und rein von meiner Vorstellungskraft her würde ich erstmal annehmen, dass sich die Teilchen in komprimierenden Sternen irgendwann gar nicht mehr bewegen können, weil die Materie zu dicht wird, und dann hätten diese auch keine Geschwindigkeit. Aber vielleicht treten da wieder andere Effekte in Erscheinung, von denen ich nichts weiß?

@Florian

Das klingt ein bisschen so, als ob oberhalb der Chandrasekhar-Grenze gleich Schwarze Löcher entstehen würden. Die Chandrasekhar-Grenze ist aber nur die Grenze für weiße Zwerge, die sie von den Neutronensternen trennt (und die dafür sorgt, dass Supernovae Typ Ia alle gleich hell sind, wenn sie durch Massentransfer überschritten wird). Die Tolman-Oppenheimer-Volkoff-Grenze, die irgendwo zwischen 1,5 und 3,2 Sonnenmassen liegt, trennt erst die Neutronensterne von den Schwarzen Löchern.

@Bruno:

Vorstellungskraft und Quantenmechanik stimmen halt leider nicht immer überein (jedenfalls für normale Vorstellungskraft). Würden sich die Teilchen in einem komprimierenden Stern irgendwann gar nicht mehr bewegen, wäre die Unschärfe in der Geschwindigkeit null und die im Ort klein. Und das würde der Unschärferelation widersprechen. Andere Effekte braucht es da nicht.

(Man sollte aber erwähnen, dass das so wie Florian es beschrieb nur mit Fermionen funktioniert. Bosonen, für die das Pauli-Prinzip nicht gilt, erzeugen keinen so großen Quantendruck. Deshalb spricht man oft auch vom Fermi-Druck.)

@Bruno

Die „Wahrscheinlichkeit, dass eine hohe Geschwindigkeit auftriit“ ist nicht ganz das, was man sich im Alltag unter einer Wahrscheinlichkeit vorstellt (wenn ich eine Wahrscheinlichkeit habe am Samstag sechs richtige im Looto zu haben, habe ich am Sonntag nicht ein bisschen geld und ein bisschen kein Geld…).

Was eigentlich gemeint ist, ist, dass der Zustand der Elektronen eine Überlagerung aus unterschiedlichen Geschwindigkeitszuständen ist – Wahrscheinlichkeiten kommen erst ins Spiel, wenn man die Geschwindigkeit tatsächlich misst.

Ich habe das in meiner QM-verstehen-Serie ausführlicher erklärt, vielleicht hilft das:

https://scienceblogs.de/hier-wohnen-drachen/2013/01/05/quantenzustaende/

@Sven und @MartinB, danke für eure Erläuterungen. Glaub mein Hauptproblem ist, dass es keinen intuitiven Zusammenhang gibt zwischen Ereignissen auf Quantenebene und dem was man als normale Materie wahrnimmt.

Gibt bei mir auf jeden Fall eher Kopfschmerzen lange darüber nachzudenken 😉

Tja, wenn man sich diese Theorien so durch den Kopf gehen lässt, dann ergeben sich zwei Möglichkeiten: Entweder sind die Physiker völlig bekloppt – oder das Universum ist es. Ich fürchte, die zweite Möglichkeit trifft zu. 😉

Die Herleitung aus der Unschärferelation empfand ich beim ersten Lesen als absurd, bis der Prof. heute den Schwarzschildradius aus der Formel 0.5 mc^2 = GM/R hergeleitet hat. Aber wenn das richtige rauskommt, ist es nicht automatisch falsch 🙂

Sehr schöne Serie Herr. Freistetter!

[…] Löcher entstehen, wissen wir mittlerweile recht gut. Ich habe das früher schon hier oder hier erklärt: Wenn ein großer Stern mit dem Vielfachen der Sonnenmasse am Ende seines Lebens keinen […]