Man könnte meinen, es wäre einfach, die Qualität wissenschaftlicher Arbeit zu bestimmen. Gute Forschung ist gut und schlechte Forschung ist schlecht und wer gute Forschung publiziert ist ein guter Wissenschaftler und bekommt gute Jobs. Aber in der Realität läuft es anders. Es kommt da nicht so sehr auf die Qualität der Arbeit selbst an, sondern auf die Zeitschrift, in der sie veröffentlicht worden ist. Oder auf die Anzahl der Publikationen, die man produziert. Das ist in gewissem Sinne auch verständlich, denn es ist schwer die Qualität einer wissenschaftlichen Arbeit objektiv zu bestimmen. Oft weiß man schlicht und einfach noch nicht, ob sich die Arbeit irgendwann als wichtig herausstellen wird oder nicht. Oder es sind nur ein paar Spezialisten überhaupt in der Lage, die Qualität der Arbeit zu beurteilen. Leider hat sich auch in der Wissenschaft der Drang zu scheinbar einfachen Kennzahlen durchgesetzt und deswegen dominiert dort heute der Impact Factor. Diese Zahl unterscheidet „gute“ von „schlechten“ wissenschaftlichen Zeitschriften und je mehr Arbeiten man in einer „guten“ Zeitschrift publizieren kann, desto besser wird auch die eigenen Karriere beurteilt. An vielen Universitäten wird sogar das Budget der einzelnen Institute anhand des Impact Factors der Mitarbeiter berechnet. Wer in den „guten“ Zeitschriften veröffentlicht, bekommt mehr Geld das den anderen, die nur in „schlechten“ Journals publizieren abgezogen wird.

Das ist natürlich ein klein wenig absurd. Der Impact Factor soll ja eigentlich die „Bedeutung“ einer Zeitschrift messen. Je öfter andere Zeitschriften Artikel eines bestimmten Journals zitieren, desto größer ist der Impact Factor. „Wichtige“ Zeitschriften werden oft zitiert; „unwichtige“ dagegen kaum und deswegen müssen auch die Forschungsergebnisse in den „wichtigen“ Zeitschriften wichtiger sein…

Diese Art der Beurteilung hat vielleicht noch vor ein paar Jahrzehnten Sinn gemacht, als es kein Internet gab. Damals musste man tatsächlich noch die Zeitschriften selbst lesen. Man musste die entsprechenden gedruckten Hefte in die Hand nehmen, darin blättern und nach interessanten Neuigkeiten suchen. Und natürlich kann man nicht alle Zeitschriften regelmäßig lesen; dafür gibt es einfach zu viele. Daher haben sich die diversen Zeitschriften für spezialisierte Forschung entwickelt; eigene Journals für Himmelsmechaniker; für die Erforschung großer Seen, für Dendrochronlogie oder chemischen Müll. Es haben sich aber auch „wichtige“ Zeitschriften entwickelt, die allgemein die bedeutendsten Forschungsergebnisse publizieren. Wer dann ein „Nature“ oder „Science“ Heft las, konnte sicher sein, zumindest über die wichtigsten Entwicklungen in der Wissenschaft informiert worden zu sein.

Aber mittlerweile laufen die Dinge ja anders. Niemand mehr geht in die Bibliothek um dort in Zeitschriften zu blättern. Die Wissenschaftler benutzen verschiedene Online-Datenbanken um dort per Stichwort nach neuer Literatur zu suchen. Es ist egal, ob ein Artikel in „Nature“ publiziert worden ist oder in den „Memorie della Società Astronomica Italiana“ oder sonst irgendeinem bekannten oder weniger bekannten Journal. Alle wissenschaftlichen Arbeiten sind in der Datenbank und wenn sie relevant für mich sein könnten, werden sie bei meiner Suche auftauchen. Ich bin nicht mehr darauf angewiesen, dass „gute“ Zeitschriften mir die „wichtigen“ Artikel heraussuchen, denn dank dem Internet kann ich mittlerweile alle Artikel durchsuchen. Es gibt keinen vernünftigen Grund mehr, zwischen „wichtigen“ und „unwichtigen“ Journals zu unterscheiden und die ganze Sache mit dem Impact Factor hat keinen Sinn mehr, außer den Leuten vorzugaukeln es gäbe eine einfache und simple Methode, gute von schlechter Forschung zu unterscheiden.

Es ist auch ein Mythos, dass der Peer-Review bei den „guten“ Journals besser wäre als anderswo. „Peer-Review“ ist ja nichts, was von den Journals selbst abhängt. Die Gutachter, die beurteilen ob die Artikel veröffentlicht werden sollen oder nicht sind ja nicht bei den Zeitschriften angestellt. Das sind ganz normale Wissenschaftler die diese Gutachtertätigkeit kostenlos erfüllen. Jeder Wissenschaftler, der selbst Artikel publiziert wird früher oder später mal von einer Zeitschrift angeschrieben und um ein Gutachten gebeten werden (das passiert sogar mir ab und zu noch, obwohl ich schon seit einiger Zeit selbst keine wissenschaftlichen Facharbeiten mehr veröffentliche). Die Gutachter werden ausgewählt, weil sie in der Lage sind, das Thema des Artikels zu verstehen und angesichts der großen Spezialisierung die mittlerweile in der Wissenschaft vorherrscht ist die Gruppe potentieller Gutachter bei einem Artikel der bei einer „guten“ Zeitschrift eingereicht wird identisch mit der Gruppe der Gutachter aus denen eine „schlechte“ Zeitschrift auswählen kann. Wenn, dann ist die Qualität der Artikel bei den „guten“ Journals eher schlechter. Denn damit die ihren hohen Impact Factor erhalten können, müssen sie immer spektakulärere Artikel veröffentlichen, die dann auch entsprechend oft zitiert werden. Das führt dazu, dass die Zeitschriften nicht immer so genau hinsehen, wenn sie die Chance haben, scheinbar beeindruckende Ergebnisse zu publizieren und dort mehr Müll durchrutscht als anderswo. Tatsächlich steigt die Anzahl der Arbeiten die zurück gezogen werden müssen mit dem Impact Factor an (siehe zum Beispiel „Retracted Science and the Retraction Index“, Fang et al 2011). Und von den ganzen Problemen mit dem mangelnden Zugang zu den Arbeiten will ich hier gar nicht reden…

Es ist schwierig, hier etwas zu ändern. Das System mit den Verlagen und den Zeitschriften hat sich mittlerweile festgesetzt obwohl es eigentlich nicht mehr nötig wäre. Dank dem Internet ist es egal, in welcher Zeitschrift eine Arbeit publiziert worden ist, wichtig ist nur, DAS sie publiziert wird. Die Wissenschaftler könnten ihre Arbeiten genau so gut gleich direkt bei irgendwelchen Datenbanken einstellen, ohne den Umweg über die Verlage zu gehen. Wissenschaftler bekommen für ihre Fachpublikationen ja kein Geld sondern müssen höchstens noch dafür bezahlen; sie würden also kein Geld verlieren sondern eher etwas sparen. Es wäre auch nicht mehr Arbeit nötig: Bei den Journals muss man die Artikel ja mittlerweile sowieso druckfertig layoutet einreichen. Und die Qualität? Wer überprüft dann, dass kein Müll publiziert wird? Es spricht eigentlich nichts dagegen, dass Peer Review auch ohne Verlage durchgeführt wird. Das könnte die wissenschaftliche Community genau so gut selbst organisieren. Momentan spielt jeder Wissenschaftler immer wieder mal freiwillig und unbezahlt den Gutachter für andere Arbeiten. Warum soll man nicht auch ab und zu mal freiwillig und unbezahlt den Editor spielen, eine eingereichte Arbeit zugewiesen bekommen, ein paar Gutachter auswählen und anhand der Ergebnisse entscheiden ob sie veröffentlicht wird oder nicht?

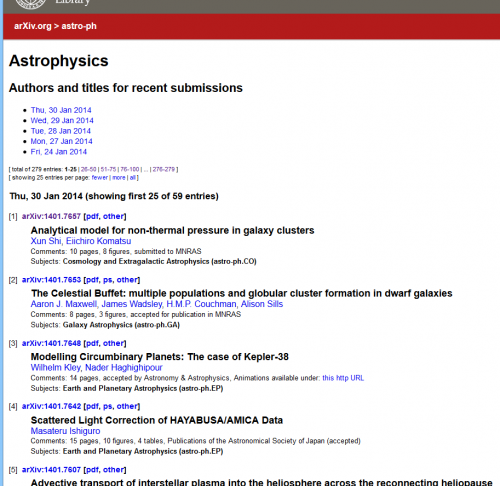

Man könnte natürlich auch das System des Peer Review völlig modifizieren. Man könnte einfach alle Artikel in einer Datenbank veröffentlichen (natürlich macht es Sinn, ein paar formale Kriterien einzufordern um den gröbsten Müll vorab zu selektieren) und den Review erst danach durch die Community durchführen zu lassen. Wenn man dann einen bestimmten Artikel in der Datenbank sucht, dann findet man eben nicht nur den eigentlichen Text sondern dazu auch gleich die gesammelten Kommentare der Kollegen (und natürlich kann man auch darauf achten, dass dort nicht einfach jeder Internettroll seine Kommentare abgibt, sondern nur angemeldete, namentlich identifizierte Benutzer). In gewissen Bereichen funktioniert das ja auch schon ein bisschen. Bei ArXiv stellen täglich hunderte Wissenschaftler ihre neuen Arbeiten ein und sie können dort von jedem frei gelesen werden. Meistens sind es Arbeiten, die zuerst schon anderswo in „echten“ Journals publiziert worden sind. Aber immer öfter werden Arbeiten gleich direkt bei arXiv publiziert.

Ich schreibe heute eigentlich nur deswegen über dieses Thema, weil ich einen interessanten Artikel im Euroscientist-Blog gelesen haben. In „Mentors, mates or metrics: what are the alternatives to peer review?“ schreibt Arran Frood wie sich die führenden Zeitschriften mit dem Problem der Messung wissenschaftlicher Qualität auseinandersetzen (oder nicht auseinandersetzen). Ich kann euch die Lektüre des Artikels nur empfehlen. Mich hat ein Satz dort ganz besonders zum Nachdenken gebracht:

„Perhaps it’s time to limit the number of papers or pages a scientist can publish.“

Das ist ein wirklich faszinierender Gedanke! So lange die Anzahl der Publikationen und deren Impact Factor weiterhin die Karrieren in der Wissenschaft dominieren, ist die Versuchung groß, bei den Veröffentlichungen mehr auf Quantität als auf Qualität zu achten. Das, was sonst in nur einem langen Artikel publiziert worden wäre, wird nun in zwei oder drei kürzere aufgespalten. Leute, die eigentlich nichts mit der eigentlichen Forschungsarbeit zu tun hatten, werden trotzdem als Ko-Autoren geführt, um deren Publikationsliste zu verlängern. Und so weiter. Wenn jeder Wissenschaftler pro Jahr nur eine bestimmte Anzahl an Artikeln (als Erstautor?) publizieren könnte, wäre das vielleicht ein Anreiz, wieder mehr auf die Qualität zu achten.

Ob das allerdings auch praktisch durchführbar ist, ist eine andere Sache. Wer sollte so eine Regeln durchsetzen? Wie sollte sie konkret aussehen? Vermutlich ist so eine Beschränkung utopisch – aber Variationen davon sind durchaus machbar. Schon seit 2010 darf man bei Förderanträgen an die Deutsche Forschungsgemeinschaft (DFG) nur noch maximal fünf Publikationen im Lebenslauf anführen. Regelungen dieser Art wären sicherlich auch bei Stellenausschreibungen, Berufungen bzw. Bewertungsverfahren aller Art sinnvoll.

Ich bin froh, dass ich bei diesem ganzen Spiel mittlerweile nicht mehr mitspielen muss. Aber es wäre trotzdem wichtig, dass sich die Dinge langsam ein wenig ändern. Die Ära der gedruckten Zeitschriften ist zumindest in der Wissenschaft schon lange vorbei. Sie erfüllen den Zweck, den sie früher erfüllt haben, schon lange nicht mehr. Es wäre an der Zeit, das zu akzeptieren und die veralteten Strukturen an die digitale Realität anzupassen!

Schön geschrieben. Gerade die Nature/Sience-Manie ist mMn absolut kontraproduktiv.

Ein kleiner Schritt um die Publish-or-Perish-Spirale abzuweichen wäre schon gegeben wenn nicht nur die Gutachter anonym blieben, sondern auch die Autoren. Es passiert leider viel zu oft dass Paper angenommen werden nur weil ein „berühmter“ (weil schon er/sie schon viele Nature/Science-paper aufzuweisaen hat) Letztautor auf dem Paper steht. Frei nach dem Motto :“ Wenn DER das eingereicht hat MUSS es ja gut sein“

@strahlenbiologie: „Ein kleiner Schritt um die Publish-or-Perish-Spirale abzuweichen wäre schon gegeben wenn nicht nur die Gutachter anonym blieben, sondern auch die Autoren. „

Ja, das sollte eigentlich Standard bei den Journals sein. Aber selbst wenn, wird es noch schwierig. Denn so speziell wie die Spezialgebiete mittlerweile sind, kann man meistens schon anhand des Themas erkennen, wer da geforscht haben muss…

Ein Paper, das am MIT erarbeitet wurde, zeigt zudem, dass es den so genannten Matthäus-Effekt tatsächlich gibt: darüber, ob eine wissenschaftliche Arbeit weite Anerkennung findet, entscheidet nicht (nur) ihre wissenschaftliche Qualität, sondern vor allem (auch) das Renommee ihrer AutorInnen.

Ich stimme dem ganzen zwar größtenteils zu, aber ich finde man sollte auch die Seite der Investoren betrachten.

Ich kann wohl kaum erwarten das jeder potentielle Investor sich zu 100% mit dem Thema auskennt. Da helfen halt die großen Peer-Review Zeitschriften, da man weis das Wissenschaftler die dort etwas veröffentlicht haben wohl ansatzweise Ahnung von dem haben was sie machen.

Wenn man aber in Zukunft jede Studie in der BILD Zeitung veröffentlicht ist die gefahr wohl größer das man im schlimmsten Fall irgendeinem Esoteriker das Geld in den hintern pustet.

Wobei das bei Seiten wie ArXiv wohl eher nicht der Fall sein dürfte.

@Markus: „Ich stimme dem ganzen zwar größtenteils zu, aber ich finde man sollte auch die Seite der Investoren betrachten.

Ich kann wohl kaum erwarten das jeder potentielle Investor sich zu 100% mit dem Thema auskennt. Da helfen halt die großen Peer-Review Zeitschriften, da man weis das Wissenschaftler die dort etwas veröffentlicht haben wohl ansatzweise Ahnung von dem haben was sie machen.“

Investoren?? Was haben Investoren damit zu tun? Hier gehts um Wissenschaft? Und warum sollten Wissenschaftler, die nicht in „wichtigen“ Zeitschriften veröffentlicht haben, keine Ahnung haben? Ich hab im Artikel ja lang und breit erklärt, dass der Impact Factor nichts mit der Qualität der Arbeit zu tun hat.

„Wenn man aber in Zukunft jede Studie in der BILD Zeitung veröffentlicht ist die gefahr wohl größer das man im schlimmsten Fall irgendeinem Esoteriker das Geld in den hintern pustet.“

Warum sollte jemand auf die absurde Idee kommen, wissenschaftliche Arbeiten in einer Boulevardzeitung zu veröffentlichen? Kann es sein, dass du von einer völlig anderen Art der Veröffentlichung sprichst bzw. dir unter „wissenschaftlicher Arbeit“ es völlig anderes vorstellst?

Das Problem sehe ich ähnlich. Ich bin jetzt 1 Jahr dabei, arbeite an meiner 2. Publikation und fühle mich so im Vergleich, als dass das schon zu wenig war Ich würde gerne auf arxiv veröffentlichen, aber die Koautoren und mein Chef wollen lieber zu den großen Konferenzen. Da hieß es mal: „du kannst jetzt bei X einreichen, aber da haben wir schon was. Reich besser bei Y ein, dann kann ich das abhaken.“

Das mit der Finanzierung ist auch ganz schlimm. Wir werden nach Anzahl Paper(!) bezahlt, also nichtmal impact factor oder irgendeinem qualitativ sinnvollen Maß. Naja, aber da hörts noch nicht auf, wir werden auch nach der Anzahl der Studenten bezahlt, die pro Semester bestehen(kine Qualitätsanfordrungen) und ein Teil unserer Finanzierung ist davon abhängig, wieviel Drittmittel wir kriegen. Drittmittel werden auch vorgeschrieben, wieviele MillionenEUR wir da jedes Jahr sammeln müssen (nicht im Sinn von: soviel brauchen wir jetzt, sondern: soviel müssen wir mehr kriegen als letztes Jahr.) Üblicherwise wird einfach der Wert alle 2 Jahre verdoppelt, damit irgendwlche corporate goals wie „wachstum“ umgesetzt werden können.

@ulfi “ Ich würde gerne auf arxiv veröffentlichen, aber die Koautoren und mein Chef wollen lieber zu den großen Konferenzen. Da hieß es mal: “du kannst jetzt bei X einreichen, aber da haben wir schon was. Reich besser bei Y ein, dann kann ich das abhaken.”“

Aber bei arxiv kannst du die papers doch trotzdem immer noch einstellen, oder?

Ich stimme Dir in weiten teilen zu. Mit Datenbanken hat man potentiell alle Veroeffentlichungen zur Verfuegung und Science/Nature etc. veroeffentlichen viel, was sich spektakulaerer anhoert als es dann tatsaechlicht ist.

Publish or perish bedeutet, dass ich als PostDoc heute viel mehr produzieren muss um eine Professur zu ergattern als das meine Chefs damals mussten. Viele Berufungskommissionen bewerten Kandidaten nach Metriken, die Quantitaet stark gewichten.

„Double blind review“ funktioniert nur in einigen Feldern, z.B. Medizin oder Soziologie. In meinem Feld der Umweltwissenschaften, wo Feldexperimente durchgefuert werden kann man das abhaken, weil der Ort und damit die Gruppe zentral im Manuskript ist.

Trotzdem wuerde ich den Impact-Faktor nicht als ueberflussig bezeichnen, weil er immerhin aussagt, dass Paper aus einen Journal gelesen und zitiert werden. Wenn mir in einer Datenbanksuche alle Artikel angezeigt werden, dann sollten sich, wenn man Reputation eines Journals ausser acht laesst, die IF ueber Zeit angleichen, wenn die Qualitaet der Paper die gleiche ist. Ausserdem haben high-impact Journals auch einen besseren Zugriff auf Reviewer…

Mein Eindruck ist, dass wir in der Wissenschaft ein gewaltiges Problem mit der Qualitaetskontrolle haben, aber bislang habe ich noch keine Loesung gehoert, die mich in der Praxis ueberzeugt.

@Tobias: „Trotzdem wuerde ich den Impact-Faktor nicht als ueberflussig bezeichnen, weil er immerhin aussagt, dass Paper aus einen Journal gelesen und zitiert werden. „

Wenn, dann würde es höchstens Sinn machen, Impact-Faktoren für einzelne papers zu berechnen. Denn natürlich ist es interessant zu wissen, wie oft ein paper zitiert wird oder nicht. Aber bei Zeitschriften machts keinen Sinn. Ein paper wird nicht automatisch wichtig, nur weil die Zeitschrift wichtig ist. Ein paper ist wichtig, wenn es selbst wichtig ist. Oder denkst du dir „Hey, diese Zeitung hat einen hohen Impact-Faktor. Da les ich jetzt mal ALLE artikel, die dort erscheinen!“ – das macht doch heutzutage keiner mehr…

Impact Faktoren eines einzenlen Paper sind ja nur die Nummer der Zitationen. Das macht bei Papern die 2 und mehr Jahre alt sind ja auch Sinn. Bis dahin braucht man aber schon einen Proxy um herauszufinden welche 20-30 von den 12000 Papern die mir meine Web of Science Suche ausspuckt ich als erstes lese.

@Tobias: „Bis dahin braucht man aber schon einen Proxy um herauszufinden welche 20-30 von den 12000 Papern die mir meine Web of Science Suche ausspuckt ich als erstes lese.“

Die, die für deine Arbeit relevant sind oder die, die dich interessieren?

Ich weiß ja nicht auf welchem Gebiet du arbeitest und ob die Dinge da so ganz anders ablaufen als in der Astronomie. Aber ich würde nicht auf die Idee kommen, einen Artikel nur deswegen als „wichtig“ genug für die Lektüre einzuschätzen, weil er bei Nature/Science erschienen ist. Ich lese die Artikel, die für mich relevant sind – egal in welchen Journal sie erschienen sind.

@Florian: natuerlich lese ich alles was fuer mich wichtig ist. Ich bin Meteorologe und habe auf dem Tibetischen Plateau gearbeitet. Deswegen habe ich viel z.B. aus chinesischen und japanischen Journals gelesen und auch zitiert.

Wobei man meiner Meinung nach schon bei einigen Journals einen Unterschied in der Qualitaetskontrolle sieht.

Was ich meinte, ist dass wenn ich eine Suche in einer Datenbank starte, dann bekomme ich i.d.R. mehrere hundert Treffer und muss dann selber entscheiden, was ich davon lese. IF oder Reputation des Journals ist dann fuer mich auch eines der Auswahlkriterien, wenn ich mehr Paper mit interessanten Abstracts habe als ich lesen kann (Nature und Science sind im uebrigen fuer mich fast voellig uninteressant, weil mein Forschungsgebiet nicht global genug ist).

Florian, ehrlich gesagt verstehe ich die Argumentation hier nicht.

Du beschreibst zunächst, warum der Journal Impact Factor kein gutes Maß ist, um die Qualität eines Papers oder eines Autors zu bewerten. Ok, sehe ich auch so. Weiterhin argumentierst Du, wenn ich richtig verstehe, dass auch die Bewertung eines Jpurnals über den Impact Factor belanglos ist, weil heutzutage niemand mehr Journals in Papierformat von vorne bis hinten liest. Deshalb seien Autoren frei, ihre Paper zu publizieren wie und wo es ihnen günstig erscheint. Für das Ansehen des Papers sollte das keine Rolle spielen, da die Qualitätskontrolle (d.h. Peer Review) überall gleich ist. Dem kann ich nur eingeschränkt zustimmen. Es mag ja sein, dass das Review bei Nature/Science nicht besser ist als bei soliden Durschniuttsjournals. Aber am unteren Ende der Skala tummeln sich durchaus viele Journals, deren Review eher lasch ist.

Was ich überhaupt nicht verstehe, ist Dein Argument zu Ende des Posts: „So lange die Anzahl der Publikationen und deren Impact Factor weiterhin die Karrieren in der Wissenschaft dominieren, ist die Versuchung groß, bei den Veröffentlichungen mehr auf Quantität als auf Qualität zu achten.“

Was hat die bedauerliche Fixierung auf den Impact Factor mit der ebenfalls bedauerlichen Fixierung auf Quantität zu tun? Ich weiß ja nicht, wie das in der Astronomie so ist. In den Feldern, in denen ich mich einigermaßen auskenne (Neurobiologie, Psychologie) ist es eher umgekehrt: kaum eine Publikation in den ganz großen (Nature, Science, Neuron, Current Biologogy, etc.) oder mäßig großen Journals (Journal of Neuroscience, Cerebral Cortex, Psychological Science) besteht aus einem einzigen Experiment; meistens wird eine ganze Versuchsreihe vorgestellt. Ich finde es eher typisch for Low-Impact Journals, dass dort „smallest publishable units“ veröffentlicht werden. Ich verstehe nicht, warum die Fixierung auf Impact Factors die Leute dazu bringen soll, kleinteiliger und weniger substantiell zu publizieren.

Umgekehrt verstehe ich nicht, wie eine Begrenzung der Paper, die ein Wissenschaftler veröffentlichen darf, die Fixierung auf Impact Factors reduzieren soll. Würde nicht eher das Gegenteil eintreffen? Wenn ich im Leben nur 10 Paper publizieren dürfte, würde dan nicht meine Motivation steigen, dass diese Paper ein Impact-Feuerwerk sein müssen?

@enbeh: „Was hat die bedauerliche Fixierung auf den Impact Factor mit der ebenfalls bedauerlichen Fixierung auf Quantität zu tun? „

Ich hab nicht behauptet, dass sie etwas miteinander zu tun hätten. Das ist kein Artikel über den Impact Factor, sondern einer über die Publikationstätigkeit in der Wissenschaft. Es geht darum, dass Publikationen die Karrierebewertung in der WIssenschaft dominieren. Je mehr Publikationen, um so besser. Je mehr Publikationen in „high-impact“ Journals, um so besser. Ich habe allerdings nicht gesagt, dass der Impactfactor was mit der Quantität zu zun hat.

Aber bei arxiv kannst du die papers doch trotzdem immer noch einstellen, oder?

Die Arbeit von und bei arXiv ist verdammt gut und wichtig – doch leider ist die Plattform nicht für alle Fächer offen (und das Anmeldeprozedere etwas lästig, aber das ist nebensächlich). Daneben gibt es viele andere Initiativen die Qualität und Verfügbarkeit von Publikationen wieder zu steigern (immer mal wieder Thema auch hier auf SBs).

Leider aber sind es oft nicht die Doktoranden (oder manchmal sogar die PostDocs), die entscheiden ob, was und wo publiziert wird (und in Firmen ist die Entscheidung noch mal eine andere). Professoren spielen oft immer noch: Nature/Science -> PNAS/EMBO/Lancet/oder so -> „normales Journal“ -> low impact. Und darüber vergeht so viel Zeit, dass der eine oder andere Doktorand/PostDoc längst weiter gezogen ist – und vielleicht schon (weil nicht genug publiziert, sic!) aus der Wissenschaft draussen.

Das wird langsam weniger, aber der Generationswechsel zu einer offeneren Sicht ist noch nicht vollzogen.

Im Übrigen teile ich die Sicht von enbeh (#13) – abgesehen davon, dass für das „Impact-Feuerwerk“ nicht in jeder Lebensphase die Zeit ist.

Sehe das ebenfalls differenziert: Klar sind die großen Journals mit ihren immensen IF völlig überbewertet, aber auch das andere Ende der Skala ist nicht zu vergessen. Allein bei uns (Geowissenschaften) gibt es so dermaßen viele „kleine“ Journals, fast schon Hausjournals von den jeweiligen geologischen Diensten oder „regionale“ (was auch mal ein Land oder Kontinent betrifft) Journals, wo dann der Editor auch mal schneller Paper durchwinkt.

Ein offenes,(entweder doppelt anonymisiertes [schwierig, weil je nach Berufsfeld meist doch klar ist, wer da publizieren will] oder völlig offenes System [keine Anonymisierung der Reviewer, die sich gerne wegen Häme oder Engstirnigkeit verstecken]) ist schön, aber schweirig, weil die Qualität der Begutachtung NICHT überall gleich ist (auch in Abhängigkeit der Editoren). Aber du hattest ja eine Alternative erwähnt: Einen „Peer“ als Editor vorschlagen. Ist aber auch nicht ohne, weil auch damit eine Menge (unbezahlter) Arbeit einhergeht.

Ne Menge los im Publikationsbusiness. Bin gespannt, wann endlich die Nachvollziehbarkeit von Experimenten durch die (Teil-)Veröffentlichung der Daten fundiert wird. Selbst „Größen“ wie Science/Nature haben ja des öfteren mal Sachen zurückziehen müssen, weil die Daten gefälscht/erfunden waren.

Da ist auch noch ein anderes Problem, das beim Peer Review häufig auftritt: Die Reviewer haben oft nicht wirklich Ahnung von dem Thema des Papers. Ist zumindest mir schon ein paar Mal passiert, dass ich Papers bekommen habe, für deren Beurteilung ich nicht wirklich qualifiziert bin. Man versucht dann halt nach besten Kräften ein faires Gutachten zu geben aber das ändert halt nichts an der Tatsache, dass man eigentlich nicht genügend über das Thema weiß um eine qualifizierte Einschätzung zu geben.

@Compuholic: „Die Reviewer haben oft nicht wirklich Ahnung von dem Thema des Papers. Ist zumindest mir schon ein paar Mal passiert, dass ich Papers bekommen habe, für deren Beurteilung ich nicht wirklich qualifiziert bin. „

Ja, sowas passiert leider immer wieder. Ich hab auch schon öfter Artikel/Projekte abgelehnt bekommen, weil der Reviewer offensichtlich ahnungslos war und irgendeinen „Fehler“ gefunden hat, der nicht da war, sondern nur aus mangelndem Verständnis des Themas resultiert ist. Das ist dann halt ne Frage des Editors: Wenn der schlecht ist, dann wählt er auch schlechte Gutachter aus…

@Compuholic und Florian

Da spielt dann meiner Meinung nach zum Teil wieder die Reputation des Journals eine Rolle. Ein Class A journal ist eher in der Lage das Paper einem Editor zu geben der was von dem Thema versteht und dann auch gute Reviewer findet.

Class A heisst übrigens nicht zwangsläufig „Closed. Access.“ Gerade z.B. die Euroean Geosciences Union hat richtig gute OA journals, die auch mit die hoechsten IF haben (zumindest für Meteorologie und Klima). Im Endeffekt stimme ich TN zu.

@Tobias: „Ein Class A journal ist eher in der Lage das Paper einem Editor zu geben der was von dem Thema versteht und dann auch gute Reviewer findet.“

Da würde ich nicht unbedingt zustimmen. Ein Journal, dass sich auf irgendein Thema spezialisiert hat – und damit i.A. keinen großen Impact Factor hat – hat in dem jeweiligen Spezialgebiet oft eine viel bessere Übersicht und viel bessere Kontakte als ein „wichtiges“ Journal das über alle möglichen Themen berichtet. In meinem Arbeitsgebiet hat zB „Celestial Dynamics and Dynamical Astronomy“ kein Problem damit, die führenden Leute auf dem Gebiet als Referees/Editoren zu gewinnen. Wohingegen man bei unter den Mitarbeitern von Nature/Science keine Himmelsmechanik-Experten findet…

@ Florian:

Ok, ich glaube wir sind hier bei Unterschieden zwischen Disziplinen und bei Definitionen. In meinem Feld (Meteorologie) gibt es eine große Gruppe von Journals, die die komplette Meteorologie abbilden (z.B. Journal of Geophysical Research: Atmosphere) und dann noch eine Reihe von Journals, die sich auf eine Untergruppe spezialisiert haben (z.B. Boundary-Layer Meteorology oder Agricultural and Forest Meteorology). Für mich sind das jedoch alles A-Journals, weil sie gelesen werden, auch wenn der IF der Spezialjournals kleiner ist.

Es ist sowieso unseriös IF über Disziplinen zu vergleichen, da der Publikationszyklus und damit auch der 2-year IF von Fach zu Fach unterschiedlich ist.

In Biosciences sind IF=10 gut, in meinem Feld ist IF=2-5 exzellent.

Nature und Science überfliege ich persönlich nur und würde die in meinem Feld auch nicht als besser bewerten als die oben genannten Journals.

Ich denke schon, dass die European Geoscience Union in die richtige Richtung geht. Deren Journals (z..B. Atmospheric Chemistry and Physics, ACP) haben eine sehr geringe „rejection rate“ ( 70%) und die Editoren pruefen hauptsaechlich die grundlegende Qualitaet und stellen dann das Manuskript zur oeffentlichen Diskussion (plus zwei anonyme Referee). Das kommt einer Datenbank, wie Florian sie sich vorstellt, eigentlich recht nahe.

Fuer Professorenstellen wuerde ich es mir auch wuenschen, dass man nur z.B. fuenf Paper einrechen darf. Ich habe es erlebt, dass gute Paper geviertel wurden, weil dann der gesamte IF hoeher ist.

Tja… ich schätze die Wissenschaftler sind auch irgendwie die Opfer der renomierten Magazine. Nein, ich finde nicht das man die Anzahl der Publikationen begrenzen sollte. Das ist zu restriktiv, das eigentliche Problem sitzt aber an einer anderen Stelle: monopolisierung von Wissen; Paywalls. Das Schlimmste ist das es auch den Austausch von Wissen behindert. Die… sagen wir mal… den äußeren Gegebenheiten angepasste Arbeitsweise (sprich Beeinflussung der Art und weise wie gearbeitet wird um maximalen Profit zu erziehlen) ist ebenfalls eine logische Folge dieser Vorgehensweise. Ich bin der Meinung wenn es die Arbeit negativ beeinflusst, so ist es an der Zeit sich über eine neue Vorgehensweise Gedanken zu machen.

Ach, ich denke die Kritik ist überzogen. Letztlich funktioniert das Publikationssystem wie es ist doch ganz gut – insbesondere auch die Mischung aus Fachjournalen, Fachübergreifenden Journalen (wie eben Science/Nature), ,Open Access, arXiv und – was oft vergessen wird – den Homepages der Autoren.

Ich habe weder den Eindruck (falls falsch: Bitte Belege), dass wichtige wissenschaftliche Erkenntnisse wegen des Publikationssystems nicht bekannt geworden sind, noch dass die Top-Journale ihre Blätter mit unwichtigem Zeug von prominenten Autoren zumüllen.

Eine Begrenzung? Naja, das ist sicherlich nicht sinnvoll. Wie soll das schon praktisch funktioniert: Das die ATLAS-Kollaboration dann nur noch 5 Artikel veröffentlichen (WRINT: CMS & ATLAS nicht ALICE 😉 )? Warum soll man Autoren, die einfach einen hohen Output haben (Edward Witten, Theodor Hänsch, J. Ignacio Cirac…) künstlich einschränken? Zensur ist immer falsch. Das die Publikations/Zitationszählung allerlei ungute Anreize für Wissenschaftler setzt: Klar. Dennoch funktioniert es ja ganz gut.

Aus meiner kurzen wissenschaftlichen Laufbahn kann ich selbst sagen: Ja, das Einreichen von Zeitschriftenartikeln und Konferenzbeiträgen ist extrem mühsam. Man fühlt sich zum Teil unfair behandelt und es kann sehr demotivierend sein. Nur: Auch Forscher müssen „Marketing“ betreiben. Wenn ich denke, dass ich wichtige Erkenntnisse gewonnen habe, dann muss ich als Wissenschaftler eben als Teil meiner Arbeit auch darum kämpfen, dass diese bekannt werden.

Ich denke nicht, dass ein System funktionieren kann, in dem alle ihre Arbeiten bei arXiv abwerfen und darauf vertrauen, dass die wichtigen Arbeiten durch Schwarmintelligenz schon nach oben gespühlt und bekannt werden.

Was ich noch als am problematischsten Ansehe, das sind Zitationszählungen und Zitationsrankings. Vor allem, weil diese oft durch grosse Kollaborationen (CERN, die SCP/High-z Supernova Search), die Anbieter von Tools (eklatant in der Molekularbiologie durch Bioinformatik-Tools, aber auch in den Materialwissenschaften) oder durch Review-Artikel (z.B. PDG in der Elementarteilchenphysik) dominiert werden und damit stark verzerrt werden.

@Christoph: „. Letztlich funktioniert das Publikationssystem wie es ist doch ganz gut „

Nun, wenn du das meinst… Du sagst, deine wissenschaftliche Laufbahn ist noch kurz. Vielleicht kommt ja dann bei dir irgendwann noch der Punkt, wo du das nicht mehr so siehst. Wenn du dich irgendwo bewirbst und merkst, dass nur die Anzahl der Papers auf der Publikationsliste zählt und nicht der Inhalt. Oder wenn dein Kollege mit dem Nature-Paper den Job kriegt und nicht du, obwohl du eigentlich besser qualifiziert wärst, usw.

Das Problem am Publikationssystem ist der immer stärkere Drang, die Qualität des wissenschaftlichen Outputs durch eine simple Kennzahl zu beschreiben. Deswegen wird der ganze Unsinn von Impact Factor, Zitationsindex, etc ja immer noch so zelebriert und der Nature/Science/Cell-Wahn wird immer stärker. Und dem muss man entgegen wirken.

Und von der ganzen Open-Access-Sache haben wir hier noch gar nicht geredet…

@Florian #25

Nein, wissenschaftliche Laufbahn – zumindest im akademischen Bereich – war kurz. Zum einen bin ich in der glücklichen Lage in einem Bereich zu arbeiten – der Informatik – wo es auch ausseruniversitär gute Möglichkeiten gibt und diese auch noch gut bezahlt werden.

Ja, ich hätte problemlos eine Postdoktorandenstelle bekommen, alleine schon, weil ich einen in meinem Feld prominenten Doktorvater hatte, der mich dann auch noch an einer international Top-Uni betreut hat. Natürlich ist solch ein akademischer CV erstmal ein Pfund mit dem man wuchern kann – ich denke aber auch zu Recht. Natürlich hat das bei einer Bewerbung Gewicht, noch bevor sich jemand überhaupt irgendeine Publikationsmetrik geschweige denn eine Publikation selbst angeschaut hat. Dennoch bin ich ausgerechnet an meinen beiden Wunsch-Arbeitsgruppen nicht angenommen worden – ja, da gibt es eben dutzende Bewerber auf 2-3 Stellen. Ja, andere hatten in prominenteren Journals publiziert und evtl. das etwas „hippere“ (was hoffentlich in vielen Fällen auch „wichtigere“ bedeutet) Themengebiet beackert. Ich denke aber – im Gegensatz zu Dir – dass diese Personen die Stellen ebenso verdient haben – vielleicht habe die einfach etwas besser gepasst. Es ist nunmal ein harter Wettbewerb. That’s life. Als ich meine Wunschstellen nicht bekommen habe, habe ich die Uni eben verlassen- aber ohne Groll. Warum auch: Ich habe ja keinen Anspruch darauf, dass mich irgendwann eine Universität auf eine W2/3-Stelle setzt, die mir doch mehr oder weniger himmlische Freiheiten böte. Und wenn mir die Chancen darauf zu gering erscheinen, dann muss ich mich halt anderweitig umsehen.

Gerade den Impact-Factor halte ich nicht für grundsätzlich schlecht. Ich würde schon die These in den Raum stellen, dass in Nature absolut wie relativ mehr bedeutende Arbeiten erscheinen als im Hintertupfinger Journal für allgemeine Wissenschaften oder in einem Journal ohne jegliches Review (so kommen ja Esoteriker auf Publikationen in „Fachjournalen“). Dass eine einzelne Nature-Publikation der „Jackpot“ sein kann, das mag bitter sein. Aber eine Leistung ist es imho trotzdem dort eine Publikation unterzubringen. Klar: Wie immer findet man Einzelfälle, in denen irgendwas nicht funktioniert. Klar werden teilweise falsche Anreize gesetzt (z.B. zu Slicing).

Ich sage nicht, dass alles rosig ist. Aber deine Artikel und Statements scheinen mir aus der persönlichen Enttäuschung heraus doch etwas sehr einseitig. Du wirkst auf mich im Augenblick wie ein Fussballer, der nach einer Niederlage alle Schuld beim Schiedsrichter abladen will. Das mag ungerecht gegenüber Dir sein, aber so kommt der Artikel und auch die WRINT-Folge für mich im Augenblick rüber.

Ich sehe das Problem auch nicht umbedingt bei den Journals, sondern bei den Univerisitaeten. Die machen es sich meiner Meinung zu einfach, bei der Bewertung von wissenschaftlicher Arbeit.

Meine Erfahrung aus Hong Kong (die das US-System kopieren) ist, dass bei Einstellung und Befoerderung von Professoren erstmal nur eine Kennzahl zaehlt, die aus IF, Publikationszahl und Zitierungen bestimmt wird. Nur wenn du es damit an die Spitze der langen Liste schaffst, wirst du weiter wahrgenommen.

Die Formel zur Berechnung ist bekannt und es lohnt sich NICHT qualitativ hochwertige Forschung (IF ~5) zu betreiben, sondern ist am besten viele einfache Paper (IF ~1) zu produzieren. Das wissen natuerlich auch unsere jungen Professoren und handeln danach.

Das „System“ verhindert also hochwertige Forschung anstatt sie zu foerdern. Ich finde das Schade, da ich gerne hochwertige Arbeit ablieferen moechte, aber dafuer im Moment bestraft werde.

Aus der Erfahrung halte ich es fuer sinnvoll, bei der Bewertung von wissenschaftlicher Arbeit nur die 5 besten Paper zu bewerten. Das waere meiner Meining nach besser fuer die Forschung (und eventuell auch fuer mich, da ich mich im Moment weigere Paper wie am Fliessband zu produzieren).

„Das “System” verhindert also hochwertige Forschung anstatt sie zu foerdern.“

Das sehe ich nicht unbedingt so. Es führt aber zu dem von mir angesprochenen „Slicing“: Man veröffentlicht seine Ergebnisse Häppchenweise um bei gleichem Ergebnis den Output an Publikationen zu steigern (Der zu eher unrühmlicher Bekanntheit gelangte Prof. Lichtenthaler war wohl ein Meister darin).

Zum Zweiten denke ich, dass das dazu führt, dass auch viel völlig Unbedeutendes publiziert wird. Ich denke nicht, dass das System „hochwertige“ Forschung zu verhindern, wohl aber starke Anreize setzt jeden „Furz“ zu Veröffentlichung zu bringen.

„Aus der Erfahrung halte ich es fuer sinnvoll, bei der Bewertung von wissenschaftlicher Arbeit nur die 5 besten Paper zu bewerten.“

Dem stimme ich zu. Auch wenn es durchaus mehr als 5 sein können – manchmal auch weniger. Ich sass als Student und Doktorant in ein paar Berufungskommisionen: Ich hatte mir von den Bewerbern immer gerne erklären lassen, was an ihren 3-10 neu und wegweisend war, was der persönliche Beitrag war etc.

Aber es stimmt schon: Insbesondere in den unteren Hälften (nach Zitierungen) der Publikationslisten findet man fast nie etwas, was irgendwie bedeutsam wäre: Oft gefüllt mit Publikationen, die max. 3 Zitierungen haben, die dann auch noch aus der gleichen Forschungsgruppe stammen (siehe auch oben).

@Christoph: “ Es führt aber zu dem von mir angesprochenen “Slicing”: Man veröffentlicht seine Ergebnisse Häppchenweise um bei gleichem Ergebnis den Output an Publikationen zu steigern „

Und deswegen der Titel dieses Artikels…

Hier ist noch ein aktueller Artikel zu genau diesem Thema: https://www.theguardian.com/science/occams-corner/2014/jan/06/radical-changes-science-publishing-randy-schekman

Bin auf diesen Beitrag gestoßen und wollte noch anmerken:

„Aber mittlerweile laufen die Dinge ja anders. Niemand mehr geht in die Bibliothek um dort in Zeitschriften zu blättern. Die Wissenschaftler benutzen verschiedene Online-Datenbanken um dort per Stichwort nach neuer Literatur zu suchen.“

Dies ist eine Dienstleistung, die Bibliotheken anbieten, die dafür Geld bezahlen, um es ihren Nutzern zur Verfügung zu stellen. Hinzu kommen Recherchekurse (Information Literacy und Teaching Library), um sich überhaupt im immer größer werdenden Djungel zurecht zu finden.

Auch der Zugang und Aufbau von Repositorien wird ganz massiv von Bibliotheken gefördert, bei ArXiv.org ist es z.B. die Cornell University Library.

Zudem fördern gerade Bibliotheken Open Access massiv, auch innerhalb der Institution (z.B. mit Open Access Fonds oder Open Access Policies,…).

Ich wollte nur darauf hinweisen, weil zu oft der Eindruck entsteht, man bräuchte Bibliotheken aufgrund ihrer veralteten Printbestände nicht mehr.

Viele Grüße

Eric

@Eric: „ch wollte nur darauf hinweisen, weil zu oft der Eindruck entsteht, man bräuchte Bibliotheken aufgrund ihrer veralteten Printbestände nicht mehr.“

Ich bin weit davon entfernt, Büchereien für überflüssig zu halten: https://scienceblogs.de/astrodicticum-simplex/2013/02/08/die-ganze-welt-in-einem-haus/