„Welche Zukunft wollen wir?“ Das war der Titel einer Veranstaltung der Zeitschrift bild der wissenschaft in Stuttgart, die ich gestern Abend besucht habe. Wissenschaftler verschiedenster Disziplinen haben sich dort mit der Leserschaft der Zeitschrift getroffen um genau über diese Frage zu diskutieren: Wie wird die Zukunft aussehen und wie können bzw. wollen wir sie haben oder gestalten.

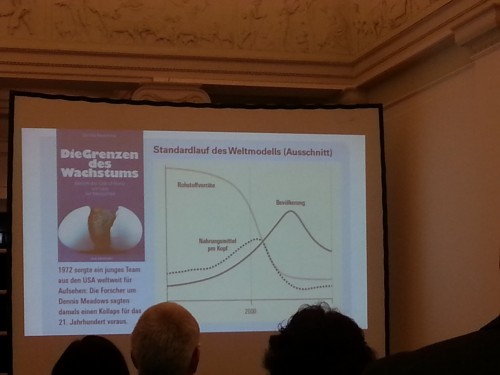

Es gab ein paar sehr interessante Kurzvorträge (und wer mehr darüber wissen will, kann dazu in der aktuellen Ausgabe von bild der wissenschaft ausführlichere Texte lesen) zu verschiedensten Aspekten der Zukunftsplanung. Eine Paläontologin hat probiert die Welt zu skizzieren die uns in 100.000 Jahren erwartet und sich große Sorgen über das Artensterben und die Biodiversität gemacht. Natürlich wurde die Frage der Energieversorgung diskutiert. Sehr spannend war auch der Vortrag über „Technofossilien“ und die Frage, was zukünftige Archäologen in 10.000 Jahren aus der Erde buddeln können. Ernst Ulrich von Weizsäcker rekapitulierte die Prognosen des Club of Rome (dessen Ko-Präsident er seit 2012 ist) und forderte eine „Neue Aufklärung“ bei der ich das Konzept allerdings nicht ganz verstanden habe – er hat es mit „Mehr Balanace statt Dogmatismus“ zusammengefasst; was damit konkret gemeint ist, hat sich mir nicht erschlossen.

Eine Frage die während der Vorträge und Gespräche gestellt wurde, möchte ich aber gerne an die Blogleserschaft weitergeben. Es ging dabei um die Forschung zur Ethik und Moral von Robotern. Künstliche Intelligenz wird ja immer relevanter – und damit sind jetzt nicht unbedingt Computerwesen á la Terminator oder HAL9000 gemeint. Sondern Maschinen wie zum Beispiel selbstfahrende Autos, die ja auch Entscheidungen treffen müssen die unser Leben beeinflussen können. Oder, wie gestern Abend angesprochen, Roboter die bei der Pflege von pflegebedürftigen Menschen helfen können; damit zum Beispiel alte Menschen länger zuhause wohnen können und nicht auf Pflegeheime angewiesen sind. Beim entsprechenden Pflegepersonal zeichnet sich ja ein ziemlicher Engpass für die Zukunft ab und künstliche Intelligenz wäre hier vielleicht ein Ausweg. Oder auch nicht; vielleicht ist es ja auch eine sehr schlechte Idee, die Algorithmen von Maschinen über die Pflege kranker Menschen entscheiden zu lassen?

Das führte gestern Abend zu der Frage, die ich hier jetzt nicht nur auf Roboter bezogen sondern viel allgemeiner stellen will:

„Welche Art von Forschung sollte man sein lassen?“

Gibt es so etwas überhaupt? Gibt es gewisse Bereiche bei denen man schon vorab sagen kann: Hier zu forschen bringt mehr Schaden als Nutzen; das lassen wir lieber bleiben? Und wenn es das gibt: Welche Arten der Forschung könnten das sein? Gestern Abend wurde das Thema nur sehr kurz gestreift aber ich denke, es verdient eine ausführlichere Diskussion. Denn genau das wird ja von der Öffentlichkeit oft gefordert: Wissenschaftler sollen dieses oder jenes bleiben lassen; sich lieber mit X beschäftigen anstatt mit Y da das nur Probleme schafft, und so weiter. Aber ich sehe da einen fundamentalen Konflikt: Forschung betreibt man, weil man Dinge wissen will, die man noch nicht weiß und oft noch nicht einmal weiß, WAS es überhaupt zu wissen gibt. Die Behauptung, eine bestimmte Richtung der Forschung wäre so schädlich, dass man sie komplett bleiben lassen sollte setzt ja aber voraus, dass man schon weiß, wie die Resultate aussehen werden. Wenn das aber so ist, dann muss man auch nicht mehr forschen. Dass es Ergebnisse der Forschung gibt, deren Anwendung Probleme schaffen kann, ist unumstritten. Wenn man versteht, wie sich Himmelskörper unter ihrer gegenseitigen Gravitationskraft bewegen, versteht man gleichzeitig auch, wie man Raketen auf andere Ländere schießen kann. Wenn man versteht, wie man Krankheiten heilen kann, versteht man auch wie sie sich verursachen lassen. Und so weiter – aber das sind wie gesagt Ergebnisse über deren Anwendung oder Nicht-Anwendung so wie bisher auch der gesellschaftliche Konsens entscheiden so muss. Aber wie sieht es mit der Forschung selbst aus? Welche Art von Forschung sollte man bleiben lassen? Gibt es darauf vernünftige Antworten? Ich bin auf jeden Fall gespannt auf eure Meinung!

Ich bin gegen jegliche Einschränkung von Forschung. Selbst wenn wir erwartbare Resultate für schädlich halten, wir wissen mit Sicherheit nicht, was sich daraus weiter ergibt. Und die Zukunft sollten wir im Großen und Ganzen unseren Nachkommen überlassen, wir haben doch nicht ansatzweise Vorstellungen über deren Fähigkeiten. Man lese nur mal alte Bücher von Zukunftsforschern/Futorologen von vor 30, 40, 50 oder auch hundert Jahren .

Erheiternd. Bestenfalls.

Und vielleicht sollten wir auch wieder etwas risikofreudiger werden. Unsere Gesellschaft lädt sich doch soviele „Bedenken“ auf(täglich mehr), daß es uns über kurz oder lang das Kreuz brechen wird.

@Pilot Pirx:

Ich glaube, Herrn Freistetter geht es weniger um eine Einschränkung von außen als um eine Selbstbeschränkung der Wissenschaftler.

Aber sonst bin ich bei Ihnen: Bei vielen Gebieten weiß man vor allem ja gar nicht, wozu man die in Zukunft überhaupt brauchen könnte. Daher halte ich Einschränkungen in der Forschung auch nicht für sinnvoll. Das heißt ja auch noch lange nicht, daß man vom Grundsatz, daß man nicht alles machen sollte, was man machen könnte, abweicht.

Zusatz: Bei der Forschung geht es ja in erster Linie darum, Wissen zu erwerben. Und man muß dieses Wissen erst mal haben, bevor man entscheiden kann, daß man einen bestimmten Teil davon vielleicht nicht auf eine gewisse Art und Weise anwenden sollte.

Abgesehen davon, daß ich auf dem Standpunkt stehe, daß es nicht schlimm ist, wenn man etwas nicht weiß, ich es aber schon schlimm finde, wenn man etwas nicht wissen will. Und der Verzicht auf Forschung in einem bestimmten Gebiet ist ja genau letzteres.

@Robert aus Wien:

Selbstbeschränkung halte ich für unendlich schlimmer.

Druck von außen kann man unterlaufen, umgehen oder sonst Wege finden. Aber wenn man sich die Freiheit selber verbietet…

Jede Forschung folgt einem Ziel – einerseits gibt es den Elfenbeinturm-Wissenschaftler, dem es nur um die Erkenntnis geht. Dem die Anwendung der Forschung egal ist – bestes Beispiel die Atombombe. Erforschung der Kernspaltung ist das eine – Grundlagen der Kernphysik. Konkrete Forschung zum Bau einer Waffe, ist moralisch fragwürdig. Wir müssen also immer zuerst einmal die Absicht hinter der Forschung und deren Nutzung klären.

Es ist aus der Sicht des „reinen“ Wissenschaftlers natürlich einfach zu sagen, dass man erst hinterher weis, was für ein Ergebnis vorliegt, weil man zu Beginn der Forschung noch nicht wusste, welche Erkenntnis vorliegt. Da stellen sich Wissenschaftler also als Stocherer im Nebel des Unbekannten dar, die nicht für ihre Entdeckungen moralisch verantwortlich sind. Andererseits werden sie natürlich strikt von sich weisen, nur auf gut Glück zu forschen, sondern betonen dass sie sich mit zielgerichteten Fragen an die Natur beschäftigen. Und genau diese Fragen sind auf ihren moralischen Gehalt zu hinterfragen. Betreibe ich Genforschung um den Menschen zu „optimieren“, betreibe ich Weltraumforschung um Raketen auf andere Länder zu schießen, betreibe ich Mikrobiologie um bessere Krankheitserreger als Waffe zu entwickeln? Diese Art von Forschung ist zu unterbinden. Vor der Entwicklung von selbstfahrenden Autos, ist die Haftungsfrage im Falle eines Unfalls zu klären. Wissenschaftler können sich nicht der Verantwortung für ihr Tun entziehen. Sonst stehen wir irgendwann an der Stelle, dass ein Wissenschaftler sagt – ups, jetzt habe ich aus reiner Neugier und Forscherdrang eine „doomsday machine“ entwickelt und gebaut, jetzt will ich doch auch wissen, ob sie funktioniert. Dient ja nur dem Erkenntnisgewinn – nach mir die Sintflut.

Das Ziel entscheidet über die Zulässigkeit der Forschung – Wissenschaftler betreiben eben nicht nur Grundlagenforschung, sondern eben auch ganz konkret anwendbares. Da steht das angestrebte Ergebnis fest. Und dort sind eben auch die moralischen Fragen zu Anwendung des Ergebnisses im Vorfeld zu klären. Solange diese nicht geklärt sind, hat die Forschung zu unterbleiben. Denn gemäß Murphys Law, wird sich immer einer finden, der das Ergebnis auch anwenden wird.

@Mikael: „Jede Forschung folgt einem Ziel – einerseits gibt es den Elfenbeinturm-Wissenschaftler, dem es nur um die Erkenntnis geht. Dem die Anwendung der Forschung egal ist – bestes Beispiel die Atombombe.“

Das ist schon der erste Trugschluss. Einstein zB saß ja nicht da und dachte: „Hey, ich überleg mir jetzt mal wie ne Atombombe funktioniert; rein intellektuell natürlich und scheiß auf die Konsequenzen.“ Einstein wollte wissen, wie Licht funktioniert. Dass daraus ein paar Jahrzehnte später irgendwann mal eine Atombombe wird war nicht absehbar. So wie das mit jeder Forschung ist. Als sich die Menschen vor Jahrtausenden/Jahrhunderten Gedanken darüber gemacht haben, wie sich die Planeten bewegen, haben sie auch nicht daran gedacht, dass man mit dem Ergebnis ihrer Überlegungen irgendwann mal Interkontinentalraketen durch die Gegend schicken wird. Hätte man aber deswegen Kopernikus, Kepler, Galileo & Newton nahelegen sollen, ihre Forschung bleiben zu lassen?

„Das Ziel entscheidet über die Zulässigkeit der Forschung „

Forschung mit „Ziel“ kannst du nur in einem ganz eng begrenzten Teil der angewandten Forschung machen. Für den überwiegenden Teil der Wissenschaft ist deine Aussage nicht anwendbar.

Was für Forschung sollte man denn unterbleiben lassen ? Konzequenzen bzgl. einer (missbräuchlichen) Anwendung sind doch meist gar nicht abzusehen. Kann CRISPR/CAS mißbraucht werden ? Bestimmt.

In der Medizin sollten vor allem zwei Arten von Forschung unterbleiben:

1. Schlechte Forschung, bei der absehbar nichts Brauchbares herauskommt, weil die Methoden für die Fragestellungen nicht geeignet sind, weil der produzierte Müll mühsam wieder aussortiert werden muss. Das Netzwerk Evidenzbasierte Medizin hat seine diesjährige Jahrestagung diesem Thema gewidmet: https://www.ebm-kongress.de/

2. Forschung, die elementare ethische Standards verletzt. In der Medizin wird versucht, das durch die Pflicht zur Genehmigung von Studien durch Ethikkommissionen einzugrenzen.

@tomtoo – ich kann auch jemanden mit einem Schild erschlagen. Missbrauch ist nie auszuschließen. Forschung hat dann zu unterbleiben, wenn das Ziel unmoralisch ist. Also z.B. den Menschen zu „optimieren“. Die Technik mag teilweise der „Heilung“ / Verhinderung von genetischen Defekten dienen. Die Grenzen sind eben nicht trenn scharf – wie von Weizsäcker sagt, mehr Balance statt Dogmatismus. Hier geht es nicht um ein Dogma des Verbietens von Genforschung, sondern um die Balance zwischen Forschung zur Heilung und Forschung mit dem Ziel ein Dogma („der optimale Mensch“) zu unterstützen. Es geht um Moral und nicht Strafgesetz. Es ist eben nicht Logik wahr/falsch, sondern Moral richtig/falsch. Überspitzt – menschliches Verhalten, gegen moralvergessenen Wissenschaftler.

Es gab mal Forschungen über objektive Minderwertigkeiten anderer Ethnien. Es wäre heikel, diese voranzutreiben, insbesondere, wenn sie denn tatsächlich ergiebig wären.

Dasselbe in grün, wurde gezielt nach tödlichen Krankheiten gesucht (bzw. die Herstellung davon), die aber nur dunkelhäutige Menschen befallen könnten.

Das käme mir so als Beispiel in den Sinn.

@Florian – „Forschung mit „Ziel“ kannst du nur in einem eng begrenzten Teil der angewandten Forschung machen. Für den überwiegenden Teil der Wissenschaft ist deine Aussage nicht anwendbar“ – trifft genau den Kern meiner Aussage. Solange keine „angewandte Forschung“ betrieben wird, ist die Fragestellung mach dem „was sollte unterbleiben“ irrelevant, da nicht beantwortbar. Für die „angewandte Forschung“ gibt es aber eine Antwort auf die von Dir gestellt Frage. Es hat alles zu unterbleiben, bei dem die moralischen Aspekte nicht abschließend geklärt sind.

Das hier gezeichnete Bild der ‚Forschung‘ ist aber doch arg idealisiert. Forschung ist durchaus nicht notwendigerweise ethisch neutral. Forschung kann – und ist es oft, wahrscheinlich sogar weit, weit überwiegend – auf ein ganz konkretes Ziel gerichtet sein und dieses Ziel kann durchaus ganz konkret z. B. massenmörderisch sein.

Als ein berühmtes Beispiel sei der vielfach geehrte und nobelpreisgekrönte Chemiker Fritz Haber genannt,der im ersten Weltkrieg seine sämtlichen Forschungsbemühungen komplett dem Ziel der möglichst effizienten Massenvernichtung von Menschen gewidmet hat.

@Mikael:

Und wer legt die gültige Moral fest?

Moral kann bestenfalls(!) ein kurzfristiges Argument sein. So ein Blitzableiter war ja auch mal ein Eingriff in Gottes Ratschluß.

Hätten sich die Menschen nach den jeweils diktierenden Moralisten orientiert, vermutlich würden wir heut noch leben wie die Steinzeitler.

@Mikael

Ich geb dir ja Recht. Ich frag mich halt wie ich das in der Forschung gezielt trennen soll. Bsp. pränatale Ultraschalluntersuchung ,tolle Sache oder ? Kann aber auch dazu genutzt werden weibliche Föten auszusondieren (siehe Indien). In der Theorie sind sich darüber bestimmt die meisten einig. Aber wie soll diese Trennung in der Praxis erfolgen ?

Mir war bei der Fragestellung auch gleich die Medizin in den Sinn gekommen, und zwar in ihrer abscheulichsten Form – die Menschenversuche der Nazis in den Konzentrationslagern. Wer würde heute eine Neuauflage mit den Worten „Ich bin gegen jede Einschränkung der Wissenschaft!“ verteidigen wollen?

Als Maxwell seinen Elektromagnetismus formulierte konnte er nicht wissen dass Einstein deshalb die Zeit relativieren würde. Als die Quantenmechanik zum ersten mal formuliert wurde, konnte man nicht wissen dass deshalb 100 Jahre später Autos autonom fahren lernen.

Das innere wirken der Physik, die Interaktion der Teilchen, so etwas zu erforschen führt zwangsläufig zu immer größeren Energien und Denkleistungen, die schlussendlich jedem von uns zum Guten oder zum Schlechten zur Verfügung stehen. Die nordamerikanischen Indianer waren den Europäern unterlegen weil sie kein geeignetes Arbeitstier hatten. Wenn sie Felder bestellten, war das mühsame Handarbeit. Es blieb neben der Ernährung weniger Zeit übrig. Entsprechend war der Stand der Technik im Allgemeinen. Sie hatten keine Chance. Nur weil sie ohne Pferde eben auf einem niedrigeren, zeitraubenderen Energielevel arbeiten mussten.

Wir haben heute Rechenleistung, Kilowattstunden und Freizeit für jeden zur Verfügung, die noch nie irgend jemandem irgendwann in der Geschichte zur Verfügung standen. Wollen wir uns davon wirklich abwenden?

Anders sieht es in der Anwendungsforschung, im Engineering aus. Müssten Roboter Sozialabgaben und ein äquivalent zur Einkommensteuer zahlen, dann würden sie tatsächlich nur die gefährlichen Dinge tun und den Rest uns Menschen überlassen.

Und gerade die ganz konkreten Anwendungen können selbstverständlich diskutiert werden. Wollen wir dass autonome Autos Millionen Arbeitsplätze in der Transportbranche plattmachen? Denn darüber redet keiner. Wer glaubt dass er in fünf Jahren in seinem VW Polo schlafenderweise zur Arbeit fährt, täuscht sich: es sind die Taxis und LKWs die es zuerst treffen wird.

Gleiches für andere Branchen. Die Biotechniker arbeiten an der bakteriellen Herstellung von Substanzen. Das ist gut, erstmal. Aber wollen wir dass sie auch Opiate herstellen? Nein. Dennoch ist es bereits passiert.

Das zeigt auch das Problem: man kann sich wünschen dass das eine oder andere nicht kommt und nicht passiert, aber verhindern kann man es wohl leider nicht. Einer wird es bauen. Da heißt es immer nur: wir zuerst oder die zuerst. Wenn wir Gesetze machen, dann ist das dasselbe wie zu sagen: Die zuerst. China hat das versucht. 1433 haben sie sich selbst eingeschlossen, die Welt ausgeschlossen und die Forschung gestoppt. Das Beispiel zeigt dass es nichts nützt. Man kommt nur ins Hintertreffen. Das ist alles. Und das ist schade.

@Joseph Kuhn:

Stimmt, da gebe ich Ihnen recht, das sind zwei Punkte, die ich nicht bedacht habe.

Aufgrund der Fragestellung von Herrn Freistetter hab ich mich eher auf Forschungsgebiete bezogen, die man auslassen sollte, aber es gibt ja auch noch andere Sichtweisen.

@Andreas zu den Opiaten:

Die spielen doch immer noch in der Schmerztherapie eine Rolle, oder irre ich mich da? Das sind doch sehr wohl auch positive Anwendungsmöglichkeiten.

Wenn man nicht verfolgt und verleumdet werden will, sollte man nicht der Propaganda in die Quere kommen und zum Syrienkrieg forschen -> https://blauerbote.com/2017/01/04/fuehrende-wissenschaftler-erlaeutern-syrienkrieg/

Fragt mal den Historiker Dr. Ganser (Friedensforschung) oder Florians Physikerkollegen Prof. Postol vom MIT in Boston (Raketen + Chemiewaffen), siehe auch den o.g. Link.

@Andreas zu den Opiaten:

Stimmt, schnell mal in der Wiki nachgeschlagen: dort steht, daß z.B. auch Codein ein Opiat ist – mir wurde erst vor einem Monat wegen meiner Grippe ein codeinhaltiges Medikament verschrieben. Also das würde ich so nicht stehen lassen.

Meiner Meinung nach sollten wir vor allem auf die liberale Gesellschaft vertrauen, d.h. im konkreten Fall:

Wissenschaftler sind keine Einzeltäter und auch keine vom Rest der Gesellschaft irgendwie durch Mauern getrennte Gruppe.

Sie bilden in ihrer Gesamtheit daher auch immer die aktuellen moralischen und ethischen Vorstellungen der Gesellschaft ab. Es gibt natürlich die Besonderheit, dass sie fachlich über das was sie tun genauer bescheid wissen und auch üblicher Weise einen höheren Fortschrittsoptimismus haben als der Durchschnitt der Gesellschaft.

Sie werden daher im Mittel Entscheidungen treffen, die vielleicht progressiv sind aber nicht diametral gegen die allgemeine gesellschaftliche Moral und Ethik verstoßen.

Zusätzlich ist in einer liberalen Gesellschaft Forschung transparent, d.h. Wissenschaftler und ihre Forschung sind öffentlich bekannt und sind über die Medien auch im Fokus der gesellschaftlichen Diskussion. Auch wenn gerne vom Elfenbeinturm gesprochen wird, so ist der eindeutig nicht so hoch und so abgeschirmt wie das manch Forscher es gerne hätte oder manch Fortschrittsskeptiker es befürchtet.

Eine sehr viel wichtigere Frage wäre für mich daher, wie identifiziert und bekämpft man gesellschaftliche unterbewusste Tabuthemen, die zu blinden Flecken in der Forschung auswachsen können.

Ich finde, die Frage ergibt in der Form nur bedingt Sinn.

Wer ist denn „man“? Woran der einzelne Forscher oder das einzelne Team arbeiten sollte oder nicht, können und müssen die ohnehin jeweils selbst entscheiden.

Aber woran von *irgendwem* geforscht wird, das lässt sich ohnehin kaum kontrollieren. Es wird sich für alles Zweifelhafte eine Interessengruppe (dazu zähle ich auch ganze Staaten) finden, die das fördern würde.

Deswegen halte ich es generell für den falschen Ansatz, Forschung einschränken zu wollen. Der dahinter stehende Gedanke, dass Forschung schlecht sein könnte, widerstrebt mir sehr.

Es sind doch konkrete Taten, die schlecht sind. Die mögen durch Forschung erst ermöglicht worden sein, aber da man die ohnehin nicht verhindern (sondern höchstens verzögern) kann, muss man das eben als Preis des Fortschritts in Kauf nehmen.

Und auch Moral ist nichts Absolutes. Was heute unethisch ist, muss das nicht auch in 50 Jahren noch sein. Jede Gesellschaft muss solche Fragen zu jeder Zeit von Neuem und für sich selbst klären.

Heute mag der Gedanke an „Designerbabys“ bei vielen Angst und Abscheu auslösen, aber auf kurz oder lang wird das normal werden.

Und das muss ja nichts schlimmes sein. Ich bin jedenfalls sehr froh, dass wir nicht vor 300 Jahren unsere Moralvorstellungen einfach eingefroren haben.

Stimmt, so weit habe ich bei den Opiate nicht gedacht. 🙂

Dennoch, ich denke man kann Forschung nicht stoppen.

Vielleicht sollten Regeln hauptsächlich die Auswirkungen dämpfen, wie in der sozialen Marktwirtschaft : Lass die Leute machen, aber schiebe den schlimmen und gefährlichen Auswüchsen einen Riegel vor oder einen steuerlichen Dämpfer.

So könnte man auch der schlechteren Forschung einen Dämpfer verpassen… wer hypothesis shopping mit Big Data tools betreibt, muss halt grundsätzlich bessere p Werte erreichen und bessere Arbeiten schreiben um trotz des Billig-Ansatzes in eine Zeitschrift zu kommen.

ca. alle 40 Jahre verdoppelt sich die Weltbevölkerung.

2050 muss Afrika 2 Millarden Menschen ernähren. Wie soll das gehen ohne weitere Forschung? Man kann sich sicher sein, das die Hohepriester (Ethikrat oder ähnliches) zielsicher genau die falschen Beschränkungen der Wissenschaft hypen würden, die bei einem „Volksentscheid“ den sogenannten „gesunden Menschenverstand“ abschalten.

@untitled – mit dem Argument „es sind doch konkrete Taten, die schlecht sind“ kann man fast jede Gefahrenvorsorge unterbinden. In den USA sind es ja auch die Menschen die andere Menschen erschießen, und nicht das Waffen für jeden unbegrenzt verfügbar sind. Ob Taten durch die Forschung ermöglicht werden oder nicht, entscheidet letztendlich der Forscher selbst. Denn das Wesen der Forschung ist doch die geistige Leistung des Forschers (bzw. seines Teams). Lässt der Forscher die Arbeit an der Entwicklung einer Waffe ruhen (ob nuklear, biologisch oder chemisch), wir diese nicht zwangsläufig von jemand anderem entwickelt. Wären die Atomwaffen nicht während des zweiten Weltkriegs entwickelt worden – wäre deutlich weniger Geld zur Verfügung gestellt worden – ob sie jemals später entwickelt worden wären? Der Gedanke, lasst uns alles machen bevor es ein anderer macht, erlaubt ist was möglich ist, die Moral ändert sich ja doch und was heute unethisch ist, musst ja in Zukunft nicht schlecht sein, also lasst es uns schon heute tun – zeugt entweder von Fatalismus oder moralischer Beliebigkeit.

Wir treffen unsere Entscheidungen heute mit unseren Maßstäben.

Die Moralvorstellungen von vor 300 Jahren – also die Vorstellungen eines Voltaire, Thomas Morus, Macchiavelli – also der Renaissance und Aufklärung unterscheiden sich doch eher marginal von unseren heutigen. Ein Macchiavelli hätte vermutlich ähnlich wie Du argumentiert, ein Thomas Morus wohl der Moral einen höheren Stellenwert als Richtschnur des menschlichen Handelns eingeräumt.

Viel Leid wäre vielen Menschen erspart geblieben, wenn Forscher selbstkritischer mit ihren Forschungsgebieten umgingen – als Beispiel wurde hier Fritz Haber genannt, es ließen sich Robert Oppenheimer und Edward Teller anführen, auch ein Wernher von Braun und erst recht „Forscher“ eines Schlages von Otmar von Verschuer sind keine Vorbilder moralische verantwortliches Arbeiten.

@Mikael: „Viel Leid wäre vielen Menschen erspart geblieben, wenn Forscher selbstkritischer mit ihren Forschungsgebieten umgingen“

Das Forschung immer auch ethisch und moralisch begleitet werden muss bzw. sollte ist trivial und selbstverständlich. Aber du kannst schlicht und einfach nicht eine direkte Verbindung zwischen Forschungsthema X und (böser) Anwendung Y ziehen. JEDE Forschung lässt sich mit ausreichend Fantasie zum Schlechten einsetzen.

@ Donkieshot:

Vor allem durch politische und soziale Reformen. Ohne eine geordnete, leistungsfähige Infrastruktur einschießlich funktionierender Verwaltungen nutzt alle Forschung nicht viel.

Wenn es so einfach wäre, müsste man ja nur das Gegenteil davon tun, was die „Ethikräte oder ähnliches“ empfehlen. Im Übrigen sind solche Gremien häufig auch mit ausgewiesenen Fachleuten besetzt – schauen Sie sich z.B. mal die Ethikkommissionen an, die über medizinische Studien entscheiden. Über Beratungsgremien pauschal zu lästern, scheint seit Trump wieder mehr in Mode zu kommen. Einfach mal loslegen, wenn’s schief geht, wird sich schon jemand finden, den man verantwortlich machen kann.

Zwar sollte man die Forschung selbst nicht einschränken, jedoch sollten nicht alle denkbaren Experimente durchgeführt werden. So lehne ich u.a. Experimente an Menschen ohne deren vorherige umfassende Aufklärung über die damit verbundenen Risiken und unnötige Experimente an Tieren generell ab.

Zusätzlich gilt, wie auch sonst, vorher nachdenken und erst danach handeln:

So sind vor dem Freisetzen irgendwelcher Stoffe oder Organismen, seien es jetzt chemische Verbindungen (Dünger, Gifte), Pflanzen, Tiere oder auch Viren, erst gründlich etwaige Auswirkungen auf die Umwelt zu überdenken. Das hätten z.B. diejenigen, die in Australien die Kanninchen zur Befriedigung ihrer Jagdleidenschaft aussetzten oder die Fischteichbesitzer, die die Asiatischen Marmor- und Silberkarpfen (das sind die schreckhaften Fische, die massenhaft bei der kleinsten Störung aus dem Wasser springen) für ihre Zuchtteiche im Süden der USA einführten (sie haben die einheimischen Fische z.B. im Illinois River fast vollständigt verdrängt), besser auch getan und darauf verzichtet. Auch die Industriealisierung der Landwirtschaft, die zur ertragssteigernden Maßnahmen mit entsprechender Freisetzung von Düngern, Giften und genmanipulierten Pollen etc. führt lässt mich fragen:

Wohin wollen wir?

Welche Auswirkungen hat unser Handeln?

Aber ich schweife ab…

Da wird Florian nicht der Einzige sein, der bei den Ausführungen des Club of Rome auf dem Schlauch steht. Deren These ist seit 1973, dass die Ressourcen des Planeten nur geschont werden können, indem die Wirtschaft Null- oder Minuswachstum praktiziert. Was damals ja stimmte, aber die Energiewende hat dieses Weltbild doch ziemlich ramponiert. Diese nämlich schafft Wachstum, schont aber die Reserven. Ehlich gesagt habe ich vom Club nie einen vernünfigen Vorschlag gehört, es läuft eigentlich immer darauf hinaus, dass wir uns mit einem Schälchen Reis am Tag begnügen sollen. Das hat man jetzt meiner Meinung nach lang genug gefördert. Eine Streichung der Gelder würde keinerlei Verlust bedeuten.

Sollten wir nicht auch überlegen, welche Wissenschaft geschützt werden muss? Wir haben erstmals in der Geschichte der USA einen Präsidenten, der mehrfach gesicherte wissenschaftliche Erkenntnisse einfach in Abrede stellt. Wenn man da mal nicht in zehn Jahren feststellen muss, dass das der Türöffner für alle Arten von Schmarrnerzählern war, die dann unwidersprochen ihren Unsinn verbreiten. Ich muss mich schon sehr wundern, dass sich der Wissenschaftsbetrieb hier so zurück hält.

Natürlich ist die Wissenschaft üblicherweise politisch neutral und äußert sich diesbezüglich nicht. Hier aber wird die Wissenschaft als solche massiv angegriffen. Das ist etwas anderes. Solidarisierung mit den Klimaleuten wäre angebracht.

@Artur57 #27

Energie ist nicht alles! Der Land- und Wasserverbrauch für die Nahrungsmittelversorgung wächst auch mit der Weltbevölkerung – ebenso wie der Bedarf an Wohnraum, Verkehr und die Abfallberge (Plastik im Meer, schwer abbaubare Gifte in der Umwelt – zur „Schädligsbekämpfung“ benutzt und in der Nahrungskette ganz unten angekommen und von Stufe zu Stufe wieder angereichert bis sie auf dem eigenen und allen anderen Tellern wieder ankommen). Da bin ich leider pessimistisch, dass wir das alles (mit mehr Forschung) in den Griff bekommen. Das Streben nach kurzfristigem, persönlichen Wohlergehen hat Vorrang vor der Vermeidung von langfristigen, allgemeinen Schäden.

@13 Pilot Pirx

Wer die Moral festlegt? Du sagst es ja selbst: Der Zeitgeist der Ethik. Dies ist natürlich vom Menschen gemacht und unterliegt Änderung in der Geisteshaltung, aber es ist auch nicht komplett variabel. Solche Dinge können sich ändern, ebenso wie Gesetze geändert werden, das macht beides doch aber nicht unbrauchbar. Im Gegenteil: Zu allen Zeiten hat sich Tun und Lassen doch auch danach gerichtet was erlaubt und opportun war (und zu allen Zeiten gab es immer welche, denen das egal war).

Wobei Ethik und Moral vielleicht eher bei der Frage eine Rolle spielt, wie man etwas erforschen sollte. Weniger dabei, was man (nicht) erforschen sollen sollte, für das „ob“ kämen allenfalls Teile der angewandten Forschung infrage. Jedenfalls sollte sich der einzelne Wissenschaftler nicht um eine ethischen Standpunkt drücken, bloß weil sich Ethik, Moral und Anstand ändern können.

@28 Arthur

Du kannst Blödsinn nicht verbieten. Ideen sind so leicht nicht totzukriegen, egal wie falsch oder bescheuert sie auch sein mögen und es wachsen immer wieder neue nach. Du kannst aufklären, du kannst dabei helfen, dass Erkenntnistheorie und Aufklärung Begriffe sind, die in der Gesellschaft präsent bleiben. Das habt die Menschheit in den letzten 200-300 Jahren doch ordentlich Hinbekommen. Und zwar trotzdem.

Also erst mal denke ich nicht, dass wir die Grundlagenforschung einschränken sollte.

Bei anderen Sachen könnte man natürlich sagen, dass es „schlimme“ Auswirkungen in der Anwendung haben kann. Dazu möchte ich die Österreichische Dokumentarreihe „Schauplätze der Zukunft“ empfehlen. Das war ein Blick in die Zukunft… aus der Perspektive von 1999. Dort finden sich Perlen wie „Eines kann sich Amerika nicht mehr erlauben – Die Welt in eine neue Wirtschaftskriese zu stürzen“, oder „Eines kann ich Ihnen versichern – in nur 10 Jahren werden die meisten von Ihnen schon mal einen Computer gegessen haben“. Kurz um, es ist nicht praktikabel möglich Dinge vorherzusagen. Man kann nicht sagen, welche Folgen eine Technologie haben wird.

Aber man kann vielleicht da, wo Forschung auf ganz konkrete Anwendungen ausgerichtet ist, aus moralischen Gründen bestimmte Dinge ablehnen.

Dass Forschung und deren Anwendung ethisch und moralisch begleitet werden, sieht man doch gerade im Zuge von CRISPR/Cas9. Gerade gestern hat die NAS dazu einen Report rausgegeben (https://www.nationalacademies.org/gene-editing/index.htm), und die Leopoldina vorgestern einen halben Tag Vorträge präsentiert. https://www.leopoldina.org/de/presse/nachrichten/gentechnik-definition Und das läuft schon eine ganze Weile.

Einstein hatte sicherlich keine Schuld an die Atombombe. Aber wie sieht es mit den Leuten in Los Alamos aus? Es war ihr erklärtes Ziel die Atombombe zu entwickeln. Auch da arbeiteten Wissenschaftler.

Ansonsten glaube ich aber auch dass weniger das Ziel ein Problem ist, als die Methode. Menschenversuche z.B. gehen gar nicht.

@pane: “ Es war ihr erklärtes Ziel die Atombombe zu entwickeln. Auch da arbeiteten Wissenschaftler.“

Ja, das war eine andere Situation. Die Leute wussten, was sie machen. Das wäre genau so eine Frage, wo die Antwort interessant ist: Wäre das Forschung, wo man sagt: Nein, das lassen wir? Und bei der Antwort sollte man bedenken, dass man die Sache nicht aus der Sicht des Jahres 2017 betrachtet – sondern aus der damaligen Gegenwart und dem Wissen das man damals hatte.

Es gibt den Unterschied zwischen Forschung und Anwendungsentwicklung. Beides ist komplex, bei beidem machen Wissenschaftler mit, aber der Unterschied ist dass die Forschung echtes Neuland betritt, bei dem man nicht unbedingt weiß was herauskommt. Anwendungsentwicklung ist eher die Frage : und was kann man damit anfangen? Da können dann durchaus einige Jahre dazwischen liegen. Oberflächeneffekte im Nanometerbereich wurden vor 30 Jahren ungefähr theoretisch beschrieben, aber jetzt erst fangen die Forscher an damit Transistoren zu bauen die auch kommerziell interessant sind.

In den Startlöchern stehen: Künstliche Intelligenz im Taschenformat, genetische Keimbahnbehandlungen welche den behandelten Embryo permanent und vererbbar verändern, Gedankenschnittstellen zum steuern von Technik, produktions- und recyclingtechniken die alles übertreffen was wir kennen und entsprechende Möglichkeiten eröffnen, und nicht zuletzt stehen die Rechner auch wieder vor einem großen Schritt nach vorne wenn man jetzt anfängt Qbits einzubauen.

Das sind alles keine Neuigkeiten sondern von der Forschungsseite her schon länger bekannt. Was interessant ist, dass Anwendungen für diese Dinge direkt dabei sind, in die Märkte einzubrechen.

Beispiel :

Auto plus billige Sensoren plus KI plus neue Rechner -> autonome Autos.

Es kommt. Aber was genau kommt, das liegt an uns. Wollen wir dass das Schulsystem von einer KI auf den Kopf gestellt wird? Ich habe mir immer gewünscht dass sich die Schule umkrempelt so schlecht fand ich sie. Aber will ich mein Kind von einem digitalen Schatten trainieren lassen? Sicher wird das Ergebnis besser als bei einem Lehrer für dreißig Kinder. Aber will ich das? Wirklich? Der digitale Schatten wüsste alles über meine Tochter wenn er lange genug mit ihr trainiert. Und wer hat Zugriff auf diese Daten? Erste Versuche laufen in Probeklassen, anscheinend Erfolgversprechend.

Ärzte haben eine Fehlerquote von 25% bis 30% bei komplizierten Diagnosen. Jede Änderung wäre gut. Aber will ich dass eine KI mich durchleuchtet um präventiv Bescheid zu sagen dass ich ins Krankenhaus soll, eine Stunde bevor ich den Infarkt kriege? Das wäre gut. Was aber wenn die KI entscheidet dass ich zu einer Quarantänegruppe gehöre und keinen menschlichen Kontakt mehr haben darf? Das wäre ja vielleicht richtig, aber es würde bedeuten dass ich die Kontrolle über meine Freiheit vollständig einem Rechner übertrage. Ist der Rechner hackbar?

Die zwei Beispiele betreffen nur die Anwendung der KI Forschung. Kombiniert man alles was in den Startlöchern steht, dann fängt man an über die Singularity von Vinge zu träumen.

Ein meines Erachtens wichtiger Beitrag zur Diskussion, nicht von mir, sondern von Friedrich Dürrenmatt: „Die Physiker“

(https://de.wikipedia.org/wiki/Die_Physiker)

Meiner Meinung nach wichtig: bei jeder Risikoabschätzung nicht nur die Risiken betrachten, die sich durch Forschung bzw ihre Ergebnisse ergeben können, sondern auch die Risiken durch die Unterlassung der Forschung.

Keine Einschränkung der Forschung. Eindeutig.

In der Aufklärung haben wir gelernt das Wissenschaft und Religion voneinander getrennt sein sollten, so dass Ideologie keinen Einfluss auf die Forschung hat.

Sobald wir nach irgendwelchen politischen oder ethischen Standards Gebiete grundsätzlich nicht erforschen (wohlgemerkt solange durch die Forschung selbst niemand zu Schaden kommt), begeben wir uns wieder in die Zeit vor der Aufklärung zurück.

PS: Es gibt schon heute Themen, die fast unmöglich zu beforschen sind. An dem Institut einer Freundin wurden kürzlich Hinweise darauf gefunden, dass Adipositas die neuronale Leistung beeinflussen kann.

Das ist schon sehr schwer an die Öffentlichkeit zu bringen, da es gleich als „Dicke sind dümmer“ und Diskriminierung von Übergewichtigen aufgegriffen wird.

Und jetzt stelle man sich vor, man würde ähnliche Unterschiede zum Beispiel aufgrund Erbanlagen, z.B. aufgrund der Ethnie finden und publizieren…

@ Lercherl:

… einschließlich der Unterlassung der Risikoforschung 😉

@ cero:

1. Politische und ethische Standards sollen Forschung also nicht lenken. Gilt das auch für die oben angesprochene Waffenforschung? Oder für Forschung zur Optimierung von Folter?

2. Sie lassen ethische Standards ausnahmsweise gelten, wenn jemand durch Forschung selbst zu Schaden kommen könnte. Was bedeutet das konkret? Ich nehme an, Sie wollen nicht die Pharmaforschung abschaffen? Und worauf begründet sich die Unterscheidung zwischen Schaden durch die Forschung selbst und die späteren Forschungsanwendungen?

3. Wenn man bei der Pharmaforschung in Kauf nimmt, dass jemand zu Schaden kommen könnte, gelten analoge Rechtfertigungen nicht auch für andere Bereiche, wenn der erhoffte Nutzen entsprechend groß ist?

4. Wenn man Forschung mit großem erhofften Nutzen für die Allgemeinheit Privilegien zugesteht, bis dahin, dass in Kauf genommen wird, dass jemand zu Schaden kommt, sind das nicht auch politische und ethische Standards?

5. Wie sieht es mit großem Nutzen für Wenige aus, z.B. für Aktionäre? Soll Forschungs bedenkenlos dem Strom des großen Geldes folgen? Wenn nicht, wie könnte man gegensteuern, wenn nicht durch politische oder ethische Standards?

Noch ein Nachtrag zum letzten Satz „Und jetzt stelle man sich vor, man würde ähnliche Unterschiede zum Beispiel aufgrund Erbanlagen, z.B. aufgrund der Ethnie finden und publizieren…“: Das ist längst geschehen, dazu gibt es Tonnen an Papier, googeln Sie mal nach Herrnstein oder bell curve.

@Joseph

Ich hab mir da gestern wirklich Gedanken über die Frage gemacht. Und musste feststellen das umso länger ich denke sich die Fragen und komplexität der Fragen geradezu exponentiell vergrößern.

Ich weis nicht ob es nur mir so geht ?

@ tomtoo:

Ja, geht nur Dir so. Uns anderen ist eigentlich alles ganz klar.

@Michael “ Forschung hat dann zu unterbleiben, wenn das Ziel unmoralisch ist“ Also z.B. den Menschen zu “optimieren”

Das mit der Moral ist immer so eine recht unkonrete Sache und unterliegt auch oftmals dem Zeitgeist oder den gesellschaftlichen Normen.

Klar sind die Experimente eines Dr. Mengele in Sachen Zwillingsforschung klar abzulehnen. Wobei wir hier ja nicht die Forschung an sich ablehnen, sondern die Methoden, mit denen sie durchgeführt werden.

Aber schon bei deiner Behauptung, es sei unmoralischen den Menschen optimieren zu wollen, scheiden sich die Geister.

Ich z.B. sehe nichts Verwerfliches daran, Erbkrankheiten im Vorfeld auszuschließen. Außerdem macht die Evolution ständig nichts anderes, als Lebewesen an ihre Umwelt zu optimieren.

@Joseph:

Ja, dafür gilt es auch. Ich habe damit zwar Bauchschmerzen und würde mir wünschen, dass eher mit anderer Intention geforscht wird, aber zu versuchen, dort eine Grenze zu ziehen ist entweder unwirksam oder schießt über das Ziel hinaus.

Sollte man erforschen dürfen wie man einen Körper möglichst schnell stark beschleunigt? Wie man das möglichst präzise tut? Und wie man das mit einer möglichst kleinen Maschine macht? Sollte man erforschen, wie man den Rückstoß einer solchen Maschine möglichst gering halten kann?

Es gibt da (leider?) keine klare Grenze.

Ich meine einfach, dass man nicht untersuchen sollte wie tödlich ein Stoff ist, indem man ihn möglichst vielen Menschen gibt. Ich wollte darauf hinweisen, dass man alles erforschen dürfen soll, aber nicht auf jedem Weg.

Der Unterschied zwischen Schaden der Forschung selbst und späteren Anwendungen ist erstens, dass die Forschung zunächst eine neutrale Beschreibung der Realität ist und damit viele verschiedene Anwendungen hat (die man vielleicht noch nicht sieht).

Zweitens kommt das Verbot von (Grundlagen-)Forschung einem Denkverbot gleich, während das Verbot von Anwendungen ein Verbot bestimmter Handlungen ist.

Das Herstellen einer Atombombe (nachdem man weiß wie das geht) dient hingegen nur einem, ethisch fragwürdigen, Zweck.

zu 3-5)

Mir ist nicht ganz klar worauf sich diese Fragen beziehen. Haben sich die vielleicht schon durch Punkt 1 und 2 beantwortet? Ich mache Forschung nicht direkt von ihrem Nutzen abhängig. Ich sage ja gerade, dass man prinzipiell alles erforschen dürfen sollte, ganz unabhängig von dem Nutzen.

Gerade bei der Grundlagenforschung ist es ja eben völlig unklar, welchen Nutzen etwas nach sich zieht.

Oder meinst du die Risiko/Nutzen-Abwägung bei bspw. medizinischen Studien? Wie in Punkt 2 erwähnt finde ich, dass das tatsächlich Sache einer Ethikkommission sein sollte. Und persönlich sehe ich den Zweck von Waffenforschung als sehr gering an.

@Joseph:

„1. Politische und ethische Standards sollen Forschung also nicht lenken. Gilt das auch für die oben angesprochene Waffenforschung? Oder für Forschung zur Optimierung von Folter?“

Ich befürchte, über solche Art von Forschung werden wir als Gesellschaft nie verbindlich abstimmen dürfen, da die Mächtigen unter dem Deckmantel der nationalen Sicherheit dieses im Geheimen weiterhin tun werden.

Und wenn es doch mal einen Untersuchungsausschuss darüber geben sollten, werden wir einfach nur einen großen Stapel geschwärzter Akten zu lesen bekommen.

@Caracalla

Da die Mächtigen(?) jedoch nicht selbst forschen, sondern forschen lassen, stellt sich doch die Frage weshalb sich reichlich Forscher finden die da ohne jeden Skrupel mitmachen?

@Bob

Der naheliegenste Grund ist da wohl die großzügige Entlohnung.

Aber sicherlich spielen da auch politische und ideologische Gründe eine Rolle – „die anderen forschen auch an Projekt XY – wir dürfen da nicht in Rückstand geraten etc“.

Schon wir man den ein oder anderen finden der sich sagt „wenn ich es nicht tue, dann wird es jemand anderes machen und außerdem wollen meine Kinder auf College“.

@cero:

Waffenforschung ist so eine Sache. Wenn man in einen militärischen Konflikt verwickelt wird, dann ist man selbst als Nicht-Kombatant doch wohl besser dran, wenn die eigenen Soldaten genauso gute oder bessere Waffen zur Verfügung haben als der Feind, oder? Es wäre auf jeden Fall ein denkbar schlechter Zeitpunkt, den Verzicht auf eine eigene Waffenforschung zu bedauern.

@ Caracalla:

Wobei so etwas ästhetisch durchaus ansprechend sein kann, siehe z.B. hier.

@Caracalla

Naturwissenschaftler oder Ingenieure haben ja nicht nur die Waffenforschung zur Auswahl. So jemand kann an vielen Stellen arbeiten und dann seine Kinder „ins College“ schicken. Das diese Gruppe alles stramme Ideologen sind ist auch schwer vorstellbar.

Vielleicht ist es einfach Gedankenlosigkeit, dass Verdrängen der Folgen des eigenen daily business? Feynman hat sowas in Zusammenhang mit dem Manhattan-Project angedeutet.

Auch das schon ein paar mal erwähnte Manhattan Projekt hätte man imho nicht sein lassen sollen.

Wenn wir die Ergebnisse von damals friedlich nutzen wollten, könnten wir damit z.B. schon zu fremden Sternen fliegen (Projekt Orion).

Dass die Bombe 1945 nicht oder anders eingesetzt gehört hätte, ist natürlich eine andere Sache. Die hätte mMn auch gewirkt wenn man sie über unbewohnten Gebiet oder vor der Küste abgeworfen hätte.

Das haben aber keine Wissenschaftler entschieden. Im Gegenteil bilde ich mir ein gelesen zu haben dass die Manhattan Projekt Mitarbeiter einen Appell verfasst haben es genau so zu machen…

Also Weizaecker’s Ulrich erklärt sich nochmal hier in einem fünf Minuten audio.

https://www.br.de/radio/bayern2/politik/radiowelt/ernst-ulrich-von-weizsaecker-club-of-rome-trump-und-die-grenzen-des-wachstums-100.html

Ansosntsen fehlten wohl einige beim Studium Generale. Das Thema wird seit den 60er Jahren behandelt. Der Name lautet Technikfolgeabschätzung und es wird hier erläutert:

https://de.wikipedia.org/wiki/Technikfolgenabsch%C3%A4tzung

Zeitung dazu wird gerade auf Online umgestellt:

https://www.oekom.de/zeitschriften/tatup.html

Waffenforschung: Ja auch deswegen gibt auf Basis des ersten Weltkrieges das Wort „Roboter“ aus einem Theaterstück von dem hier:

https://de.wikipedia.org/wiki/Karel_%C4%8Capek

An Viele: Man braucht Infrastruktur um Forschung zu machen. Da ist inzwischen ein unlösbares Henne-Ei Problem.

„Bell Curve“ ist die Gaussche Normalverteilung von Merkmalsauspägung. Mir scheint gegakpert von einem Deppen, der einiges verwechselt. Wer Luminostity kennt, weiss dass das nicht hilft – nur süchtig macht! uvam.

@Mikael

Warum ist Forschung, die den Menschen optimiert, unmoralisch? Beispiel: Nehmen wir an ein Forschungsprojekt führt zu Gen-Engineering, mit dem man z.B. dem Nachwuchs musikalisches oder naturwissenschaftliches Talent beschafft (oder auch nur eine blonde Haarfarbe, weil so gewünscht). Wo liegt da eine Unmoral? Das bringt doch die Menschheit voran.

Mir ist klar dass gen-modifizierte Menschen zu sozialen Konflikten führen können, aber andere Fortschritte haben auch zu Konflikten geführt. Beispiel: Die Erfindung der Schiffe führte zu bösen Eroberungs- und Kolonisierungskriegen. Hätten wir deshalb keine Schiffe erfinden sollen?

Ein weiterer möglicher Konflikt liegt darin, dass solche Design-Kinder sich zunächst nur Reiche leisten können. Aber in absolut jeglichen anderen Gesellschaftsbereichen akzeptieren wir auch dass Reiche überall teils exorbitante Vorteile haben, inklusive der ärztlichen Versorgung (Privatversorgung durch beste Koryphäen), der Bildung (Hauslehrer; sehr hohe Studiengebühren statt Auswahltests im Fall reicher Sprösslinge an besten Universitäten) sowie des Rechtswesens (beste Anwälte, Strafgebühren sind teilweise fix oder haben einen Höchstsatz, so dass Reiche viele Strafen im Vergleich zu Armen ungleich weniger stark spüren).

KI-Forscher gehen davon aus, dass es noch in diesem Jahrhundert zu einer Intelligenz-Explosion kommen wird, in deren Folge es zu einer existenziellen Katastrophe für die Erde kommen kann (siehe auch Nick Bostrom – Superintelligenz). Sollte man deshalb die KI-Forschung lieber sein lassen?

@Jens: „Sollte man deshalb die KI-Forschung lieber sein lassen?“

Nein. Vor allem weil ich diesen Kram mit der „Singularität“ für eine gehypte Nerd-Fantasie halte. Bis jetzt hab ich noch nix gelesen das vernünftig begründet DAS sowas passieren kann, WARUM es passieren sollte und warum es eine Katastrophe sein sollte, wenn es passiert.

Es kommt natürlich auch immer darauf an was man als „vernünftig begründet“ akzeptiert.

DASS es passieren kann, dass wir eine höhere Rechnenkapazität als Computer bauen können als das menschliche Gehirn hat, ist im wesentlichen Moores Law.

WARUM diese Kapazität dann für eine KI verwendet werden wird, liegt schlicht daran, dass es ja das erklärte Ziel der KI Forschung ist, mindestens die menschliche Intelligenz nachzubauen.

WARUm es eine Katastrophe wäre ist schlicht und einfach das Vorsorgeprinzip, wir kennen nichts vergleichbares und daher nicht die Folgen. Also wie bei Gentechnik erstmal von der Vernichtung der Welt als Standardszenario ausgehen. 😉

„Solange der Computer den Drucker nicht findet, der genau neben ihm steht, ist die Weltherrschaft der Maschinen nur ein Witz.“

@ Jens:

KI-Forschung ist doch auf technische Nutzanwendungen ausgerichtet und nicht darauf, ein künstliches Gehirn mit Selbstbewusstsein zu bauen. Was man bei KI als Intelligenz bezeichnet ist nicht dasselbe, was man bei Menschen als Intelligenz bezeichnet. Menschliche Intelligenz geht in der Regel mit Willenshandlungen einher, die sich an moralischen Standards bemisst, auf die man sich zuvor geeinigt hat.

Maschinelle Intelligenz beschränkt sich auf das reine Problemlösen, das zuvor von außen als Zielpunkt gesetzt wurde. Auch lernfähige Software gleicht den Lernerfolg an den zuvor gesetzten Fixpunkt ab. Mit dem Erreichen des Zieles ist die KI nicht in der Lage, gewissermaßen „von innen heraus“ sich neue Ziele zu setzen, da der KI eine „Innenperspektive“ fehlt.

Von daher ist das Gerede von einer „Intelligenz-Explosion“ und einer „technologischen Singularität“ wirklich nur ein moderner Mythos, dem jegliche sachliche Bodenhaftung fehlt. Sicher – Algorithmen können viel Schaden anrichten, aber das ist etwas anderes als die oft prophezeite Menschheitsdämmerung mit nachfolgender Herrschaft der Maschinen.

@Hoffman

Zum einen fehlt mir zu dem Thema die Definition von Intelligenz aus der KI Forschung ein:

Intelligenz sind immer die kognitiven Fähigkeiten die ein mensch besitzt aber nicht der Computer. Sobald ein Computer eine solche cognitive Fähigkeit reproduzieren kann, ist es nicht mehr intelligent.

Zum anderen ist die Integration von moralischen Standards eine der aktuell heißen Themen in der KI Forschung. Wir werden also bald Problemlöser haben die ihre Lösungsstrategien mit moralischen Standards abgleichen bevor sie diese umsetzen.

Und der letzte Punkt ist, dass die höchste Gefährlichkeit von der extrem intelligenten Narrow-AI ausgeht, also eine KI die ein von außen vorgegebenes Problem mit einer übermenschlich schnellen und tiefgreifenden Intelligenz löst und dabei den Menschen als lediglich Mittel zum Zweck der Problemlösung sieht und bei Widerstand beseitigt. Das ist das im wesentlichen das Grey-Goo Szenario.

@ Philipp:

Ich denke nicht, das sich Intelligenz auf kognitive Fähigkeiten reduzieren bzw. beschränken lässt. In Bezug auf KI bedeutet Intelligenz schlicht Problemlösungskompetenz, wobei das zu lösende Problem nicht von der KI selber generiert wird, sondern von außen über Menschen vorgegeben wird. Somit geht einer KI schon mal die Autonomie verlustig, die für Menschen wesenseigen ist.

Zu den moralischen Standards: Die kann man natürlich irgendwie einprogrammieren, aber für das Abgleichen ergeben sich manchmal Situationen, bei denen wir „nach Gefühl“ entscheiden und nicht nach Verstand.

Es ergeben sich bei einer KI-Lösung demnach Ergebnisse, die rein rational und mechanisch zustandegekommen sind, aber keine, die über Kontextbetrachtungen zustandegekommen sind – eine Fähigkeit, die wir z.T. über Emotionen bewältigen („fühlt es sich richtig an?“), die aber einer KI abgeht, wenn sie ihr Programm abarbeitet.

Zum Schreckensszenario einer KI, die den Menschen aktiv beseitigen will: So lange es Menschen gibt, die als Kontrollinstanz die Auswirkungen einer KI unabhängig von der KI beurteilen kann, wird es Möglichkeiten geben, bei Bedarf die Einflussmöglichkeiten einer KI auf infrastrukturelle Prozesse zu begrenzen bzw. zu reduzieren.

Ich denke nicht, dass die Entwickler von KI so naiv wären, dass sie mögliche „Durchdrehszenarien“ nicht vorab durchsimuliert hätten – einschließlich der Szenarien, wie ein solches Durchdrehen zu verhindern bzw. zu unterbinden ist. Von daher habe ich da keinerlei Bedenken, dass die Menschheit als Ganzes durch eine KI abgelöst und vernichtet werden würde. So etwas ist schlechte Science-Fiction.

@Hoffmann

Für die Gefährlichkeit sind erstmal die kognitiven Problemslösungsfähigkeiten das ausschlaggebende, ob da noch der ganze menschliche Tiefgang an „erleben“ dahinter steht ist zweitrangig.

Zum Thema Bauchentscheidungen/Gefühl ist der Zug seit AlphaGo bereits abgefahren. Diese KI hat den Menschen im Bereich des intuitiven Erfassens von komplexen Kontexten (auch Bauchentscheidungen genannt) geschlagen. Das war der große Durchbruch gewesen. Die KI hat eben nicht rational und mechanistisch einen klaren Algorithmus mit purer Rechenpower abgearbeitet. Mit dieser Methode wäre es mit der heutigen Rechenpower auch unmöglich einen Menschen beim GO spielen zu schlagen. Sondern es wurde mit einem Verfahren gewonnen, dass aus bisheriger Spielerfahrung ein „sieht besser aus/sieht eher schlechter aus“ als Entscheidungsgrundlage genommen hat. Das spannende und vielleicht auch erschreckende ist, dass von der ersten Implementierung des intuitiven Spielens bis zum Schlagen der besten GO Spieler der Welt kaum mehr als anderthalb Jahre vergangen sind.

Insbesondere bei den Börsenspekulationen werden jetzt auch immer mehr Menschen durch KIs ersetzt, da sie auf den Gebieten des Erfassens von Marktstimmungen und intuitiven Entscheidungen schon nach relativ kurzer Trainingszeit jedem Menschen auf den Heller und Pfennig nachweisbar überlegen sind.

Wie weit man eine KI eindämmen kann, die aus dem Stand heraus mehr Intuition , Kreativität und Wissen als 1000 Menschen hat, ist halt die Frage. Die vielen Gedanken die sich viele intelligente Menschen darüber machen, wie man sichere und „unknackbare“ Software baut, hat bisher Hacker auch noch nicht davon abbringen können, eben doch Mittel und Wege zu finden, dieses zu umgehen. Eine entsprechend kognitiv fähige KI mit einem breit und vage definierten Ziel wäre im Knacken menschlicher Sicherheitsarchitekturen erwartbar genauso besser und schneller als jeder menschliche Hacker wie sie die Go Spieler oder die Börsenspekulanten deklassiert hat.

@ Philipp:

Nein, für die Gefährlichkeit ist Ausschlag gebend, auf welche Bereiche eine KI angewandt wird. Und diese Entscheidung trifft nicht die KI. Weiterhin ist Ausschlag gebend, welche Kontrollinstanzen vorhanden sind, die ggf. regulierend eingreifen können. Auch hier gibt es stets Bereiche, die nicht durch eine KI abgedeckt werden. Am Ende läuft es auf den Faktor Mensch hinaus, der relevant in Bezug auf eine potenzielle Gefährlichkeit einer KI ist.

Es ging aber hierbei nicht um Spielstrategien, sondern um Agieren in Abgleich mit moralischen Normen. Du kannst Moral nicht mit Go gleichsetzen. Beim Go geht es um den Gewinn eines Spiels – wieder mal eine externe Zielvorgabe! – während es bei Moral um gutes Handeln geht. Und was moralisch gut ist, ist in der Ethik höchst umstritten. Da spielt dann das hinein, was wir „menschlich“ nennen – also etwas, was einer KI völlig abgeht.

Es gibt aber auch bereits Aktivitäten der Gegensteuerung, um sich nicht vollends von Algorithmen in ökonomischen Entscheidungsfindungen abhängig zu machen. Börsenspekulation ist übrigens auch „nur“ ein mathematisches Problem, was Rechner schneller lösen können als Gehirne. Es geht am Ende nur darum, was profitabler ist: Setzen auf steigende Kurse oder Setzen auf fallende Kurse. Der Erfolg zeigt sich am Ende in der Kursbilanz. Mehr ist das nicht.

Es ist eine Frage der Formulierung von Sicherheitsstandards, um Schäden in der Infrastruktur zu vermeiden. Am Ende der Kontrollkette muss ein Mensch stehen, der der KI notfalls die Stromzufuhr kappt, um ihr destruktives Treiben zu stoppen. Letztendlich ist es also eine politische Frage, wie sehr man eine KI agieren lässt oder nicht.

„Nein, für die Gefährlichkeit ist Ausschlag gebend, auf welche Bereiche eine KI angewandt wird. Und diese Entscheidung trifft nicht die KI. Weiterhin ist Ausschlag gebend, welche Kontrollinstanzen vorhanden sind, die ggf. regulierend eingreifen können. Auch hier gibt es stets Bereiche, die nicht durch eine KI abgedeckt werden.“

Nun da haben sie schon jetzt verloren, denn die Bereiche auf denen KI nicht angewand werden, schrumpfen dramatisch. Eines der ersten Themen was gerade anläuft ist die Infrastruktur. Und ich bin einer von denen, die an einer KI arbeiten, die die komplette IT Infrastruktur kontrolliert und managt angefangen ab ihrer DSL Dose bis hin zur CPU des Servers auf dem dieser Kommentar abgelegt wird und diese ist allgemein genug um auch das technische Management der Gebäude, der Finanzabrechnungen, die Überprüfung der Rechtmäßigkeit des Betriebs relativ zu den verschiedenen Gesetzen zu IT Systemen der verschiedenen Ländern abzugleichen …

.. und übrigens sie kann auch sehr gut Strategie Spiele spielen und das ist erst der Anfang. 🙂

„Am Ende der Kontrollkette muss ein Mensch stehen, der der KI notfalls die Stromzufuhr kappt, um ihr destruktives Treiben zu stoppen.“

Wissen sie wie moderne IT funktioniert ? Man verteilt große Anwendungen über Kontinente hinweg, so dass es keinen single Point of failure sagen wir mal durch Stromausfall gibt. Intelligente Cloud services können dabei Daten und Prozessorkapazität innerhalb von Sekunden zwischen Datencentern weltweit verschieben.

Ein Killswitch für eine Anwendung die für Funktionalität zentraler Infrastruktur sorgt, ist sicherheitspolitisch weit gefährlicher als eine allgemeine staatliche Hintertür in jeden Verschlüsselungsalgorithmus.

„Letztendlich ist es also eine politische Frage, wie sehr man eine KI agieren lässt oder nicht.“

Und ja das ist der Punkt weshalb man die Szenarien eben nicht für unrealistisches Sci-Fi halten sollte, sondern sich ernsthaft mit derer Vermeidung beschäftigen muss.

Das sehe ich nicht so. Eine KI trifft keine eigenständigen Entscheidungen, die im Chaos münden, sondern sie trifft Entscheidungen, die die Infrastruktur effizienter funktionieren lässt. Das Ziel ist vorgegeben. Die KI arbeitet lediglich alles ab, was der Zielerfüllung dient. Problematisch könnte sein, wenn Terroristen die KI hacken und andere Zielvorgaben installieren. Aber das hat dann nichts mehr mit der durchdrehenden KI zu tun, sondern mit den Sicherheitsvorkehrungen, die man als „Cyber-Abwehr“ zusammenfassen kann.

Nur dass sich diese „Killswitch“ eben nicht von selbst programmiert und installiert, sondern dazu immer noch krimineller Helfer bedarf, die aus Fleisch und Blut gewachsen sind. Was Du hier anmahnst, ist Terrorabwehr, wobei die Gefahr durch reale Menschen ausgeht, die sich der KI für ihre kriminellen Ziele bedienen.

Die KI selber ist lediglich eine „dumme Maschine“, die stumpf ihr Werk verrichtet, ohne sich darum zu kümmern, ob das anvisierte Ziel „guten“ Interessen dient oder „bösen“. Diese Unterscheidung ist nach wie vor menschliches Maß und nicht künstlich-intelligentes. Und dass jedes Werkzeug sowohl zum Guten wie auch zum Bösen verwendet werden kann, ist spätestens seit dem Faustkeil bekannt.

Es kommt also auf die an, die sich des Werkzeugs bedienen. Für eine Hysterie in Bezug auf KI besteht gar kein Anlass. Auf den bzw. die Menschen kommt es an. Aber das war schon immer so. Deshalb denke ich, dass man angemessene Lösungen finden wird, mit der hypothetischen Bedrohung durch Missbrauch umzugehen.

Und Du meinst, dass das nicht schon längst getan wird?

Danke für eure Meinung zum Thema KI-Forschung.

Kurze Anmerkung noch dazu: Mit dem „Gerede über Intelligenz-Explosion“ beschäftigen sich auch seriöse Wissenschaftler (siehe https://de.m.wikipedia.org/wiki/Nick_Bostrom). Es einfach als Spinnerei abzustempeln, erscheint mir da etwas zu oberflächlich.